Professional Documents

Culture Documents

CAP2ECON

Uploaded by

Julio PerezCopyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

CAP2ECON

Uploaded by

Julio PerezCopyright:

Available Formats

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

CAPITULO 2

EL METODO DE ESTIMACIN DE MNIMOS CUADRADOS

ORDINARIOS:

MODELO DE REGRESIN BIVARIADO

2.1. INTRODUCCIN

Una vez revisados los conceptos bsicos en el captulo 1 estamos listos para iniciar nuestro

camino con el fin de entender la forma ms utilizada de estimar los parmetros de un modelo

lineal: El estimador de mnimos cuadrados ordinarios. Como se mencion en la seccin 1.1.4 el

mtodo de Mnimos Cuadrados Ordinarios (MCO) presupone una minimizacin de la suma de

los errores elevados al cuadrado, para de ese modo estimar los parmetros de la regresin.

Recordemos que para obtener los parmetros partimos de un problema de prediccin

condicional donde el mejor predictor de Y condicional en X es una prediccin que minimiza la

prdida esperada con respecto de una funcin de prdida especfica. Esta funcin depende de

criterios arbitrarios, algunos de los cuales han sido descritos en la seccin (1.1.3):

En este captulo, iniciaremos nuestro estudio sobre la estimacin de los parmetros tomando

en cuenta el modelo de regresin bivariado, modelo de regresin simple o modelo lineal

simple. Este modelo puede ser planteado de la siguiente manera:

Yi 0 1 X i i

(2.1)

En este caso, observamos que la variable dependiente slo es explicada por una variable

independiente aparte de la inclusin del intercepto. Debe hacerse una aclaracin en este caso

porque muchos lectores pensarn que el intercepto podra ser considerado como una variable

explicativa adicional. Sin embargo, debemos recordar que el intercepto recoge el efecto

promedio de aquellas variables no incluidas en el modelo. Su inclusin no implica que exista

22

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

una relacin sistemtica entre las variaciones de una variable independiente y la dependiente por

lo que su inclusin no es importante como variable explicativa sino para guardar cierta

consistencia de los resultados.

El modelo presentado en la expresin anterior es un modelo terico. Para poder iniciar el

proceso de estimacin de los parmetros desconocidos debemos plantear nuestro modelo

emprico, el cual toma la siguiente forma:

Yi 0 1 X i ei

(2.2)

En este caso, estamos reemplazando los parmetros desconocidos por sus estimadores y el

trmino de error es reemplazado por el error emprico (e). En este caso la primera parte de la

expresin, expresada por:

Yi 0 1 X i

(2.3)

ser la parte predicha (o explicada) por el modelo. Esto representar nuestro estimado de la

media condicional de la distribucin de Y.

2.2. MTODO

DE ESTIMACIN DE

REGRESIN LINEAL SIMPLE

MNIMOS CUADRADOS

PARA UN MODELO DE

Como ya se mencion, en este modelo la variable endgena slo se explica mediante una

variable exgena fija o no aleatoria. El criterio de mnimos cuadrados ordinarios implica

resolver el siguiente problema de minimizacin:

n

Min

2

i

i 1

Con respecto a 0 y 1 , siendo :

e i (Yi 0 1 X i ) (2.4)

As, planteamos el problema de minimizacin de la forma:

Min (Yi 0 1 X i ) 2

,

0

(2.5)

si derivamos con respecto a los parmetros, obtenemos las siguientes ecuaciones de primer

orden:

( ei2 )

2 (Yi 0 1 X i ) 2 ei

0

2

i )

(Y

i

X )X

i

(2.6)

e X

i

(2.7)

Si desarollamos estas dos expresiones y las simplificamos, obtenemos las siguientes

frmulas:

23

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

Yi 0 1 X i

(2.8)

2

X i Yi 0 X i 1 X i

(2.9)

Estas ecuaciones son llamadas ecuaciones normales de la lnea de regresin. Ms adelante

veremos que cada una de ellas implica que cada regresor es ortogonal al vector de errores

mnimocuadrticos. Como vemos es un sistema de ecuaciones donde el nmero de incgnitas es

igual al nmero de ecuaciones. Si el sistema est exactamente identificado, entonces existe una

solucin nica.

Para resolver este sistema conviene plantearlo en forma matricial para luego resolverlo

utilizando para ello el mtodo de Kramer. Si escribimos el sistema en forma matricial podemos

expresarlo de la siguiente manera:

X

X

0

1

i

2

i

Y

X Y

i

(2.10)

i i

Aplicando el mtodo de solucin descrito, obtenemos las siguientes soluciones:

Yi

X i Yi

n

Xi

Xi

2

2

Xi

Yi X i X i X i Yi

Xi

n X i2 X i 2

2

Xi

Yi

X i Yi

n

Xi

1

n

Xi

Xi

2

Xi

n X i Yi

n X

2

i

(2.11)

X i Yi

Xi 2

Si se trabaja con el denominador y numerador de 1 , y los dividimos entre n, podemos

llegar a las expresiones siguientes, las cuales resultan mucho ms comprensibles en trminos

estadsticos:

2

Xi

Xi 2

n

X i2

nX

2

(2.12)

X i2 nX

24

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

( X

X )2

(2.13)

X i Yi (1 / n) X i Yi X i Yi nXY

= X i Yi nXY nXY nXY

X i Yi X i Y XY XYi

Ntese que la ltima ecuacin puede simplificarse como:

.

Yi Y X i X

(2.14)

(2.15)

Reemplazando las ecuaciones (2.13)y (2.15) en la expresin (2.11) se tiene:

Yi Y X i X Cov ( X , Y )

1

2

Var ( X )

Xi X

(2.16)

La ltima ecuacin muestra que el estimador de Mnimos Cuadrados se puede expresar en

funcin de los datos muestrales. Donde Y y X expresan las medias muestrales de la variable

endgena y exgena, respectivamente. Para simplificar podemos definir las siguientes variables:

xi X i X

yi Yi Y

Esta notacin se utilizar para representar las desviaciones con respecto a los valores medios

de X e Y, y tambin para estimar el modelo en desviaciones en un captulo posterior. Esta

representacin resulta una herramienta interesante para demostrar algunas propiedades del

estimador de MCO.

Por otro lado, el intercepto de la funcin de regresin muestral ( 0 ) puede representarse

utilizando la primera ecuacin normal y dividiendo sta entre el tamao muestral (n):

0 Y 1 X

(2.17)

Con esto se demuestra una propiedad importante del estimador mnimo cuadrtico: si el

modelo tiene un intercepto, la lnea de regresin pasa por los valores medios de Y y X.

Las ecuaciones (2.16) y (2.17) son de mucha utilidad dado que nos permiten escribir los

estimadores MCO como una funcin de estadsticos muestrales, sin necesidad de resolver las

ecuaciones normales. El primer paso consiste en calcular la pendiente de X ( 1 ), para luego

reemplazar dicho valor en la ecuacin (2.17). Para ilustrar este mtodo de estimacin

consideremos el siguiente ejemplo:

Ejemplo

25

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

El gerente de ventas de una tienda de electrodomsticos desea conocer la relacin existente

entre el nmero de artefactos vendidos y el nmero de representantes de ventas, para luego

hacer algunas predicciones acerca de las ventas del prximo ao. Para tal fin el gerente observa

las ventas efectuadas en diez das diferentes (ver la Tabla 2.1) Como se anot en la seccin

(1.1.2) se debe plantear un modelo de regresin lineal y a su vez especificar el papel que

desempea cada una de las variables en funcin al estudio que se desea realizar. Por lo tanto, en

este caso se define la variable explicativa (X) como el nmero de representantes de ventas y la

variable explicada (Y) como el nmero de artefactos vendidos.

Tabla 2.1

DAS

1

2

3

4

5

6

7

8

9

10

Totales

Xi

1

1

1

2

2

2

3

3

3

2

20

Yi

3

6

10

5

10

12

5

10

10

9

80

X i Yi

X2

Yi

3

6

10

10

20

24

15

30

30

18

166

1

1

1

4

4

4

9

9

9

4

46

7

7

7

8

8

8

9

9

9

8

80

ei Yi Yi

-4

-1

3

-3

2

4

-4

1

1

1

0

Utilizando la tabla anterior y reemplazando los datos correspondientes a las ecuaciones

normales halladas anteriormente, se tiene:

80 10 0 20 1

166 20 0 46 1

Si se despeja de la primera ecuacin el intercepto y se reemplaza dicho valor en la segunda

se obtienen los siguientes estimadores MCO:

0 6

1 1

Evidentemente, si utilizamos las ecuaciones obtenidas a travs del mtodo de Kramer,

tambin se deben obtener los mismos resultados. La comprobacin queda para el lector.

Se puede utilizar el ejemplo anterior para hallar la funcin de regresin muestral, es decir la

regresin de Y con respecto a X. Formalmente:

Yi 6 X i

Si se sustituyen las observaciones muestrales de X en la ecuacin anterior, obtenemos la

sexta columna de la Tabla 2.1 (Yi ) . Estos valores representan las estimaciones de la variable

dependiente obtenidas a travs de los parmetros calculados por el mtodo MCO. Comparando

estos valores con aquellos observados para la variable dependiente hallamos los errores

26

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

correspondientes a cada observacin de la muestra. Debido a que el modelo incluye un

intercepto o trmino constante, se verifica que la suma de errores estimados es cero.

Hasta aqu el lector ya debe estar apto para estimar una regresin bajo el mtodo de Mnimos

Cuadrados Ordinarios y debe tener claro los siguientes conceptos: regresin, parmetros, lnea

de regresin, estimadores, estimacin, errores estocsticos. En la siguiente seccin, se detallarn

las propiedades del estimador mnimo cuadrtico, las que como se ver, resultan de suma

importancia para el anlisis de regresin.

Algo importante que debe recalcarse es que todo estimador es una funcin de los datos y

como stos pueden cambiar en cada muestra tenemos que sern variables aleatorias. Alguien

podra decir que si las X estn fijas siempre tendremos la misma muestra pero pensando de

dicha forma se dejara de lado la naturaleza aleatoria de Y que, sabemos, depende del vector de

errores. Estos errores no son fijos y si tomamos una nueva muestra podran variar lo que

implicara un nuevo valor de Y para cada realizacin de la muestra.

Si reemplazamos en nuestro estimador una muestra determinada (valores observados de

variables aleatorias) obtendremos los estimados. Por tanto, un estimado es un valor particular de

la funcin de los datos (estimador) cuando utilizamos una muestra en particular. Es importante

hacer esta distincin porque las propiedades que se analizarn ms adelante se referirn a la

variable aleatoria llamada estimador.

2.3. PROPIEDADES DEL ESTIMADOR MCO

Bsicamente son dos la propiedades muestrales que nos interesan analizar del estimador

MCO. Estas son el insesgamiento y la eficiencia. Intuitivamente la primera se refiera a que el

centro de la distribucin del estimador es igual al parmetro verdadero mientras que la segunda

nos asegura que nuestro estimador ser el de varianza mnima lo que nos dar una mayor

seguridad porque el grado de imprecisin inherente ser menor. Estas dos propiedades son

aquellas que denominaremos de muestras pequeas.

2.3.1 Insesgamiento del estimador MCO.

Formalmente la propiedad de insesgamiento se puede establecer de la siguiente forma:

E E ( ) 0

Esto quiere decir que el centro de la distribucin del estimador de mnimos cuadrados

ordinarios coincide con el verdadero valor del parmetro. Si se cumple esta propiedad podemos

usar con cierta tranquilidad nuestro estimador porque sabremos que cada estimado que

obtengamos provendr de una distribucin cuya media es el verdadero valor del parmetro por

lo que el estimado ser equivalente, en trminos estadsticos al verdadero parmetro 1.

Para verificar esta propiedad, recordemos la expresin del estimador MCO:

1

(Yi Y )( X i X ) Cov( X ;Y ) xi yi

Var ( X )

( Xi X )2

xi 2

(2.28)

Trabajando con el numerador:

1

Debemos mencionar que ello no implica que nuestro estimado particular sea exactamente igual al verdadero

parmetro. De hecho podramos tener otra muestra y obtener otro estimado. Si el estimador es insesgado, entonces

este nuevo estimado tambin podremos utilizarlo e interpretarlo como equivalente, en trminos estadsticos, al

verdadero parmetro.

27

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

( X i X )(Yi Y ) ( X i X )Yi Y ( X i X )

y dado que ya conocemos que

ecuacin (2.28), de la forma2 :

( X i X ) 0 , podemos reexpresar el numerador de la

xi yi xi Yi

(2.29)

Ahora, y por propiedades matemticas de las sumatorias, se puede expresar la ecuacin

(2.28) como:

xi

y

x 2 i

i

ki yi

(2.30)

Siendo:

ki

xi

xi 2

(2.31)

As, se dice que el estimador MCO es lineal, ya que es una funcin lineal de la variable

es una combinacin lineal ponderada de Y,

endgena (Y). Ntese que en la ecuacin (2.30),

1

donde ki representa las ponderaciones y dado que las X son fijas estas ponderaciones se pueden

interpretar como constantes.

Digresin:

Propiedades de ki :

i. Las ki son no estocsticas, debido a que las X tampoco lo son.

ii.

ki

xi

2

xi

xi 0

xi 2

Dado que xi representa la desviacin de dicha variable respecto a su media, el numerador es

siempre cero. Adems, se sabe que la suma de las desviaciones al cuadrado, para cualquier

muestra dada, es un valor conocido y diferente de cero.

iii.

ki 2

xi 2 1

2

2

xi 2 xi

iv.

xi 2

xi 2

ki xi

Ntese que nicamente el trmino Y

( Xi X )

puede ser igualado a cero.

28

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

Las propiedades anteriores son de mucha utilidad para verificar la insesgabilidad y la

eficiencia del estimador MCO, como se ver ms adelante.

Antes de revisar estas propiedades, conviene recordar que uno de los supuestos del modelo

de regresin lineal afirma que las observaciones de X son fijas, es decir, no varan si se utiliza

otra muestra de igual tamao. En cambio, no se debe olvidar que las observaciones de Y s

seran diferentes de repetir el proceso de muestreo, debido a que incluye un componente

aleatorio i cuyas realizaciones variaran al cambiar de muestra. Estos conceptos se utilizarn

repetidamente en la demostracin de las propiedades.

Con esto en mente, pasemos ahora a verificar las propiedades del estimador MCO. En primer

lugar, sustituyamos en (2.29) la ecuacin del modelo terico de regresin (1.17) para luego, y

con la ayuda de las propiedades enunciadas en la digresin, demostrar la insesgabilidad de los

estimadores

Resulta fcil comprobar que en la ecuacin (2.30) resulta indiferente multiplicar las

ponderaciones por yi o por Yi, para ello se debe reemplazar (2.29) en (2.28) . As tenemos que:

ki Yi ki ( 0 1 X i i )

ki 0 ki 1 X i ki i

k i 1 k i X i k i i

0 (0) 1 (1) k i i

0

(2.31)

En la ecuacin (2.31) se han utilizado la segunda y cuarta propiedad de ki . Ahora, y dado

que un estimador insesgado es aqul cuya esperanza matemtica es idntica al verdadero valor

del parmetro que se desea estimar, se tomar esperanzas a la ecuacin anterior.

) E ( ) E

E (

1

1

1

)

E (

1

1

k i i 1 k i E ( i )

k i (0)

(2.33)

es un estimador insesgado de . Ahora y para

Por consiguiente, se comprueba que

1

1

verificar el insesgamiento del estimador del intercepto ( 0 ), dividamos la ecuacin (1.17)

entre el tamao muestral (n) para calcular la esperanza de la expresion resultante:

Y 0 1 X

(2.34)

E (Y ) 0 E (1 X ) E ( ) 0 1 X

(2.35)

Reemplazando las expresiones (2.33) y (2.35) en la ecuacin de la lnea de regresin

muestral3(2.17) se obtiene:

0 Y 1 X

E ( 0 ) E (Y ) E ( 1 X )

3

En adelante, de no indicar lo contrario, nos referiremos a la lnea de regresin muestral o estimada, esto es,

X i .

29

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

E ( 0 ) ( 0 1 X ) E ( 1 ) X

0 1 X 1 X

E ( 0 ) 0

(2.36)

De esta manera queda comprobado que los estimadores mnimo cuadrticos de los

verdaderos parmetros, 0 y 1 , son insesgados.

2.3.2.

Varianzas y covarianzas de los estimadores de MCO

Ntese en las ecuaciones de los estimadores MCO (2.17) y (2.28), que la naturaleza aleatoria

de los mismos proviene de la variable endgena Y, la cul es estocstica debido a la inclusin

son una variable

del trmino de error en el modelo. Por consiguiente, los estimadores

aleatoria que provienen de una distribucin de probabilidad cuya esperanza matemtica es el

verdadero valor del parmetro lo que implica que es el valor con la mayor probabilidad de

ocurrencia. Adicionalmente a lo anterior, es preciso disponer tambin de medidas de dispersin

de los estimadores, de modo que se pueda juzgar el grado en que se aproximan al verdadero

valor del parmetro que se pretende estimar . De ese modo, y para efecto de contrastar si los

regresores cumplen con ciertas condiciones tericas mediante el anlisis de inferencia

y

estadstica, se hallar la expresin analtica de la varianza de cada uno de los estimadores

una medida de dependencia entre ellos, es decir la covarianza. As, y partiendo de la expresin

(2.32) tenemos:

ki i

1

ki i

1

1

(2.37)

Ahora, recordemos que la varianza puede expresarse en los siguientes trminos:

2

Var ( 1 ) E 1 E ( 1 )

(2.38)

y dado que el estimador MCO es insesgado, tenemos que:

) E

2

Var (

1

1

1

(2.39)

Sustituyendo la expresin (2.37) en (2.39), queda:

) E

Var (

1

k

i

E ( k1 1 k 2 2 ... k n n ) 2

E ( k12 12 k 22 22 ... k n2 2n 2 k1 k 2 1 2 ...2 k n 1 k n n 1 n )

(2.40)

La expresin anterior puede simplificarse si consideramos

homocedasticidad y no autocorrelacin. As tenemos que:

los

supuestos

de

30

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

E ( k i2 i2 ) k i2 E ( i2 )

2 k i2

E ( k i k j i j ) k i k j E ( i j ) 0

y, reemplazando las ecuaciones precedentes, se obtiene:

) 2

Var (

1

ki2 2

xi2

2

xi2

( Xi X )2

(2.41)

depende directamente de la varianza

Ntese en la expresin anterior que la varianza de

1

del trmino de error y mantiene una relacin indirecta con las observaciones de la muestra

tomada. En tal sentido, y dada 2 , cuanto mayor sea la variabilidad de los valores de X,

menor ser la varianza del estimador y de este modo la estimacin de 1 ser ms precisa. Por

otro lado, y dada las observaciones de X, cuanto mayor sea la varianza de mayor ser la del

estimador. Por lo tanto, para garantizar una mayor precisin en la estimacin debemos buscar

que las variables explicativas presenten mucha variabilidad.

) debemos partir de la

Por otro lado, para hallar la varianza del estimador del intercepto (

0

ecuacin de la lnea de regresin (2.18) y reemplazar la especificacin para la media de la

variable endgena (2.34) para obtener:

( X )

X

0

1

0

1

(

) X

0

1

0

1

Ahora, y dado que:

1

1

(2.42)

ki i

la ecuacin (2.42) se puede escribir como:

k X

0

0

i i

) k X

(

0

0

i i

(2.43)

Utilicemos ahora un procedimiento similar al propuesto para la varianza del estimador de la

pendiente:

) E

2 E k X 2

Var (

0

0

0

i i

) E

Var (

0

ki i 2 X 2 ( ) 2 2 X ki i

(2.44)

Dado que el valor esperado afecta nicamente a las variables aleatorias, la expresin

anterior, puede representarse como:

2X

Var ( 0 ) X 2 E ( k12 12 ... k n2 2n ) E ( ) 2

E ( k1 12 ... k n 2n k1 1 2 ... k n n 1 n )

n

31

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

) , sabemos que:

Por la demostracin de la varianza de (

1

2

E ( k12 12 ... k n2 2n )

1

( X i X) 2

y adems, por las propiedades de ki y por el supuesto de no autocorrelacin entre los errores, se

tiene que:

2

2

E ( k1 1

... k n 2

n k1 1 2 ..... k n n 1 n )

ki ki E ( i j ) 2 (0) (0) 0

Ahora, y a partir del tercer y cuarto supuesto del modelo de regresin lineal sabemos que:

E () 2 E

1

n2

( 12 22 ... 2n 1 2 ... n 1 n )

1

n2

n( 2 )

2

n

Dadas las expresiones anteriores, la varianza del estimador del intercepto se reduce a:

Var( 0 ) X 2 2

( X i X )2

2

2 X 2

( X i X )2 n

1

(2.45)

Conociendo la especificacin para la varianza de cada uno de los estimadores involucrados,

pasemos ahora a analizar su covarianza. Como sabemos, la definicin de covarianza viene dada

por:

,

)E

E (

)

E (

)

Cov (

0

1

0

0

1

1

(2.46)

dada la propiedad de insegabilidad, la ecuacin anterior puede escribirse como:

,

)E

( )

( )

Cov (

0

1

0

0

1

1

(2.47)

Ahora, recurdese que :

0 Y 1 X

y tomando esperanzas:

E ( 0 ) Y E ( 1 X ) 4

(2.48)

Restando las dos expresiones anteriores tenemos:

( ) X

0

1

0

1

(2.49)

y sustituyendo la ltima expresin en (2.47), resulta:

4

Recurdese que

Y 0 1 X , donde = 0 dado que

0 . En este caso, la presencia de un

trmino independiente resulta tambin indispensable. Recurdese que el componente aleatorio de un modelo de

i 0 . As,

regresin lineal es ortogonal al componente determinstico y, en este sentido, se verifica que: 0

E (Y ) Y .

32

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

,

) E X (

) 2

Cov (

0

1

1

1

) 2

XE (

1

1

(2.50)

Considerando las definiciones propuestas en (2.39) y (2.41), la covarianza entre los

estimadores MCO vendra dado por:

,

) XVar (

)

Cov (

0

1

1

1

X 2

2

(Xi X )

(2.51)

Resumiendo las expresiones obtenidas para la varianza y la covarianza de los estimadores

MCO, se tiene:

2

Var ( 1 )

xi2

( Xi X )2

X2

Var ( 0 ) 2

( Xi X )2

,

) X

Cov (

0

1

1

n

( Xi X )2

Ntese que las formulas anteriores pueden ser estimadas a partir de los datos muestrales

excepto por el elemento ( 2 ). Por ello, es preciso estimar mediante el mtodo de Mnimos

Cuadrados Ordinarios el valor de la varianza del modelo, pues como se recordar, la naturaleza

aleatoria de la variable endgena proviene del trmino de error, por lo que la varianza de Y

resulta igual a la varianza de .

2.3.3.

La eficiencia del Estimador MCO: El Teorema de Gauss Markov

El clculo de las varianzas y covarianzas de los estimadores MCO del modelo lineal simple

es indispensable para conocer el grado de dispersin que presenta nuestro estimador. Sin

embargo, si deseamos tener una mayor confiabilidad en nuestro estimador deberamos tener

alguna certeza que dicha varianza es la menor posible 5. Eso es lo que analiza el Teorema de

Gauss-Markov.

El teorema en palabras simples establece lo siguiente: Los estimadores obtenidos por el

mtodo de Mnimos Cuadrados Ordinarios resultan los mejores estimadores lineales e

insesgados (MELI) pues poseen la mnima varianza entre todas las clases de estimadores

lineales e insesgados.

puede escribirse como:

Para verificar esta propiedad, recordemos que el estimador MCO

1

1

5

ki Yi ki ( 0 1 X i i )

En resumen lo que se busca es determinar si el estimador MCO es eficiente.

33

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

Ahora, y con el objetivo de demostrar que este estimador es el de mnima varianza,

definamos un estimador lineal alternativo de la forma. En este caso el procedimiento que vamos

a utilizar implica analizar otro estimador arbitrario y si comprobamos que el estimador MCO

tiene menor varianza, podremos generalizar nuestro resultado al resto de estimadores lineales e

insesgados. Teniendo esto en perspectiva definamos otro estimador de la siguiente forma:

~

1

vi Yi

(2.55)

De este modo, vi representa las nuevas ponderaciones, las que no necesariamente presentan

las mismas propiedades de ki . Teniendo esto presente, pasemos a comprobar si este nuevo

estimador cumple con la propiedad de insesgamiento:

~

E ( 1 ) E

vi Yi vi E (Yi )

vi E ( 0 1 X i i )

vi

vi X i

As, para que el nuevo estimador sea insesgado se debe cumplir que:

vi

(2.56)

vi X i

(2.57)

Ntese que las dos expresiones precedentes son iguales a las propiedades de ki, enunciadas

anteriormente. Ahora, reemplazando la ecuacin (2.55) en la frmula de la varianza del

estimador, se tiene:

vi Yi

vi2VarYi

~

Var ( 1 ) Var

Como se recordar la varianza de la variable endgena es igual a la del error ( ) de modo

que la expresin anterior queda como:

2

~

Var ( 1 ) 2

2

i

(2.58)

Con el fin de escribir la expresin anterior en trminos ms conocidos, hagamos el siguiente

artificio:

v

i

xi

v

i

x i

2

2

i

2 2

x i

2

xi

xi

xi

v

i

xi

2 2

xi

xi

x i

x i

2

2

i

2

i

xi

xi

2

i

2

i

34

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

El segundo trmino de la expresin anterior es igual a cero, por lo siguiente:

v

i

xi

xi 2

vi xi

xi 2

vi

xi 2

xi 2 xi 2 2 xi 2 xi 2 2

xi

xi

xi

xi 2

xi 2

~

Este resultado se obtiene debido a que el estimador 1 es insesgado y por tanto se cumplen

~

las condiciones (2.56) y (2.57). Resumiendo, la varianza de 1 se expresa como:

~

Var ( 1 ) 2

xi

2

x i

2

x i

Si analizamos la expresin anterior, notaremos que el segundo sumando es constante e igual

(obtenida en la seccin anterior). De este modo, la varianza mnima se

a la varianza de

1

obtendr reduciendo al mximo el primer trmino de dicha expresin. Esto se logra definiendo:

vi

xi

xi 2

ki

~

, ya que la

La expresin anterior nos indica que la varianza de 1 es mayor a la de

1

nica forma de obtener un estimador de mnima varianza es utilizando las ponderaciones ki. As,

el estimador MCO posee la mnima varianza entre todos los dems estimadores lineales e

insesgados existentes. Esta propiedad tambin puede verificarse para

0 utilizando un

procedimiento similar.

Un grfico nos puede ayudar a analizar lo que el teorema de Gauss-Markov significa. Un

), como el estimador

supuesto til para este fin ser que tanto el estimador MCO (

1

~

alternativo ( 1 ) poseen una distribucin conocida que para este caso ser un distribucin

normal.

~

,

1

1

1

35

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

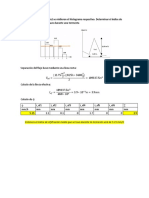

Figura 2.3

En la figura 2.1, las distribuciones muestrales de ambos estimadores estn superpuestas con

el fin de escoger el mejor predictor o estimador. Ambas distribuciones estn centradas en el

verdadero valor evidenciando la insesgabilidad de ambos estimadores. El mejor estimador ser

aquel que posea mayor probabilidad de acercarse a 1 , lo que se cumple cuando la distribucin

de probabilidad del estimador est menos dispersa alrededor del valor de su media, es decir

cuando presenta una menor varianza. Dado lo anterior, resulta sencillo verificar que el estimador

obtenido por el mtodo MCO (aquel cuya distribucin se presenta con una lnea continua) es el

mejor estimador lineal insesgado ya que posee la mnima varianza, y as su distribucin presenta

una mayor probabilidad asociada a su valor medio.

Un hecho que debe destacarse es que para que se verifique el teorema de Gauss-Markov es

necesario que se cumplan del segundo al quinto supuesto de los mencionados en el captulo 1 6.

Estos, como ya mencionamos llevan el nombre de condiciones de Gauss-Markov. Si algunos de

dichos supuestos falla, ya no es vlido el teorema por lo que el estimador MCO ya no ser el de

mnima varianza y deber buscarse la forma de transformar los datos o incluir ciertas

condiciones para que se restablezcan estas condiciones a fin de poder seguir utilizando nuestro

estimador MCO.

2.4 OTROS RESULTADOS REFERIDOS AL ESTIMADOR MCO

1. La lnea de regresin muestral a travs del estimador MCO atraviesa los puntos que

representan las medias muestrales de X e Y.

Grficamente:

FRM: Yi 0 1X i

Figura 2.1

Esta propiedad se obtiene a partir de dividir la lnea de regresin entre el nmero de

observaciones (n):

6

Estos en esencia nos dicen que la esperanza matemtica de los errores es igual a cero, que no existe ni

autocorrelacin ni heterocedasticidad y que los regresores fijos no estn correlacionados con el trmino de error.

36

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

Y 0 1 X

(2.18)

el trmino de error desaparece debido a que el promedio de los mismos es cero y por tanto

su sumatoria tambin lo ser.

2. En promedio, el valor estimado de la variable endgena es igual a la media del valor

observado de dicha variable.

Este resultado se puede comprobar fcilmente, partiendo de la ecuacin de la funcin de

regresin muestral y haciendo algunas operaciones algebraicas, tal como se detalla a

continuacin:

Yi 0 1 X i

(2.19)

Si se reemplaza la ecuacin (2.18) en (2.19), se tiene:

Yi Y 1 X 1 X i

Yi Y 1 ( X i X )

(2.20)

Tomando sumatorias a la ecuacin (2.20), se obtiene:

Yi nY 1 ( X i X )

(2.21)

Se puede comprobar fcilmente que la suma de las desviaciones de una variable, (llmese

dependiente o independiente), con respecto a su media muestral es siempre igual a cero, de

modo que:

(2.22)

(X i X ) 0

As podemos reexpresar la ecuacin (2.21) de la forma:

Yi nY

(2.23)

y, dividiendo entre el tamao muestral:

Y Y

(2.24)

El procedimiento anterior nos permite afirmar que el modelo estimado es representativo. Es

decir que, en promedio, las estimaciones de la variable endgena (realizadas sobre la base de

datos muestrales), representan a sus contrapartes poblacionales.

3.

La media de los errores estimados es nula.

Recurdese que el proceso de minimizacin que nos permiti estimar los coeficientes de

regresin gener dos ecuaciones (llamadas ecuaciones normales). La primera de ellas (2.6) es la

representacin de esta propiedad7:

7

De hecho, la presencia de un intercepto o trmino independiente resulta crucial para la validez de esta propiedad, tal

como se verificar posteriormente. Ntese, adems, que la comprobacin de esta propiedad est basada en la

ecuacin normal del intercepto.

37

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

(Yi 0 1 X i ) 0

ei

Por otro lado, y si trabajamos con las expresiones anteriores, tenemos que:

ei (Yi 0 1 X i )

ei Yi Yi

ei

Y Y 0

n

(2.25)

debido a la igualdad propuesta en (2.24)8.

4.

El error estimado no est correlacionado con el valor estimado o predicho de la variable

endgena.

Lo anterior, garantiza que el mtodo de MCO cumple con el supuesto de ortogonalidad entre

la parte explicada del modelo de regesin lineal simple y la parte no explicada. Formalmente:

Yi ei 0

(2.26)

Para demostrar esta propiedad basta reemplazar la funcin de la lnea de regresin muestral

(1.18) en la expresin anterior:

( 0 1 X i ) ei 0 ei 1X i ei

0 ei 1 X i ei 0

(2.27)

Ntese que en (2.27) los coeficientes de regresin (el intercepto y la pendiente) estn

multiplicados por la primera y segunda ecuacin normal, respectivamente. Como resultado del

proceso de minimizacin se tiene que dichas ecuaciones son idnticas a cero, por lo que queda

demostrado que la parte predicha o estimada del modelo no guarda relacin alguna con la parte

no explicada o estocstica.

2.5 ESTIMACIN MCO DE

Hasta el momento hemos estimado nicamente los parmetros del modelo propuesto pero

an nos queda la estimacin de una ltima magnitud: la varianza del error. Ntese que hasta el

2

momento cuando obtuvimos la varianza de los estimadores el trmino sta qued

8

En este caso la presencia de un trmino independiente tambin resulta indispensable ya que, de otra forma, no sera

posible realizar la sustitucin propuesta en (2.20).

38

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

expresado en trminos tericos. Para poder estimar la varianza de los parmetros y la propia

varianza de la variable dependiente necesitamos un estimador de esta magnitud.

Una de las formas ms utilizadas para la estimacin de la varianza del error parte del modelo

terico y de su representacin en promedios muestrales:

Yi 0 1 X i i

Y 0 1 X

a partir de las cuales obtenemos:

Yi Y 1 ( X i X ) ( i )

yi 1 x i i

(2.52)

Recurdese que el residuo o error estimado puede expresarse como:

ei Yi 0 1 X i

Yi (Y 1 X i ) 1 X i (Yi Y ) 1 ( X i X i )

e y x

i

1 i

De este modo, reemplazando (2.52) en la ltima ecuacin se obtiene:

ei ( 1 1 ) xi i

As, elevando al cuadrado y sumando a ambos lados, resulta:

ei2 ( 1 1 ) 2 xi2 2( 1 1 ) xi ( i ) ( i ) 2

y, tomando valores esperados se tiene:

E(

ei2 ) E ( 1 1 ) 2 xi2 E 2( 1 1 ) xi ( i ) E ( i ) 2

(2.53)

Analizando la expresin anterior, el primer sumando se reduce a , por ser un componente

de la varianza del estimador de 1 . Mientras que el segundo sumando se obtiene mediante el

procedimiento siguiente:

2

E ( 1 1 )

n

xi ( i ) E

k j

j 1

x

(

)

j

i

i

j 1

Ntese que, E j ( i ) 0 , excepto cuando (i = j ). De esta manera, el trmino

anterior resulta:

k i xi E i ( i ) 2

xi2

xi2

Por ltimo, trabajando con el tercer sumando se tiene:

39

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

( i ) 2 i2 2 i 2

2

i2

n

i2 n i

1

y tomando esperanzas:

E

) 2 n 2 2 ( n 1) 2

De esta manera, y reemplazando las expresiones anteriores en (2.53) concluimos que:

E

e

2

i

2 2 ( n 1) 2 (n 2) 2

Por consiguiente, y dado que el estimador MCO de

insesgamiento, se tiene que:

2 ) E

E (

ei2

n2

1

E

n2

(2.54)

debe cumplir con la propiedad de

e n 1 2 (n 2)

2

i

Por consiguiente, el estimador MCO de la varianza del error para el modelo lineal simple

viene dado por la siguiente expresin:

N

2

i

i 1

(2.55)

N 2

2.6 MEDIDAS DE BONDAD DE AJUSTE

Por lo revisado hasta el momento, sabemos que el criterio de Mnimos Cuadrados Ordinarios

garantiza que la lnea de regresin obtenida es la que proporciona la menor suma de cuadrados

de residuos de todas las que se podran obtener si se trazan a travs de los valores observados de

X e Y. Sin embargo, en algunos casos el ajuste puede ser muy bueno o perfecto cuando todas las

observaciones caen sobre la lnea de regresin, mientras que en otros pueden no obtenerse tan

buenos resultados. As, se hace necesario considerar la bondad de ajuste de la lnea de regresin

dado el conjunto de observaciones. En otras palabras, se desea verificar qu tan bueno es el

ajuste de la lnea de regresin a los datos, o cun cerca estn las predicciones del modelo con

respecto a las observaciones reales. De hecho, al construir un modelo estamos suponiendo una

estructura que gobierna el comportamiento de la variable dependiente. As, la bondad de ajuste

nos permite conocer el grado en que esta estructura recoge el comportamiento de la variable

endgena, dadas las observaciones muestrales. La medida propuesta para tal fin se denomina

coeficiente de determinacin, conocido tambin como r- cuadrado (r2 o R2 en el caso de una

regresin lineal simple o en el de una regresin mltiple, respectivamente).

2.6.1.

Cmo se calcula el coeficiente de determinacin?

Para el clculo del r2 se debe partir del modelo de regresin emprico, el cul puede

escribirse de dos formas:

Yi 0 1 X i ei

40

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

Yi Yi ei

Como se sabe, se puede expresar el modelo en desviaciones restando a la primera ecuacin

la expresin de la lnea de regresin, del modo siguiente:

(Yi Y ) 1 ( X i X ) ei

yi y i ei

En la expresin anterior, resulta indiferente escribir ei o (ei e ) , pues recurdese que

e 0 por la primera ecuacin normal. Luego, elevando dicha expresin al cuadrado y tomando

sumatorias, se tiene:

yi2 yi2 ei2 2 yi ei

Por la cuarta propiedad del estimador MCO, se sabe que el tercer sumando de la ecuacin

anterior es igual a cero, de modo que:

yi2 yi2 ei2

(2.59)

Podemos expresar la ecuacin anterior de modo tal que resulte ms conocida en trminos

estadsticos9:

(Yi Y ) 2 (Yi Y ) 2 ei2

(2.60)

Cada una de las expresiones anteriores estn relacionadas con sus respectivas varianzas.

Segn ello, podemos descomponer la varianza de la variable endgena en dos partes: una

explicada por el modelo a travs de la regresin lineal estimada y otra que el modelo no es

capaz de explicar debido a su naturaleza estocstica. Pasemos ahora a definir los componentes

de la expresin (2.59):

yi2 , suma total de cuadrados de la variable explicada(STC)

yi2 , suma explicada de cudrados (SEC)

ei2 ,

suma residual de cuadrados (SRC)

Ahora, y dado que se busca medir el grado en que nuestro modelo recoge el comportamiento

de la variable endgena, nuestra medida de bondad de ajuste (r2 ) vendra dada por el cociente

entre la SEC (variacin de Y explicada por el modelo) y la STC (variacin registrada para la

variable explicada):

2

2

2

) y

i2

y i e i

ei

Var ( Y

i

1

2

2

Var ( Yi ) y 2

yi

yi

i

(2.61)

Una condicin necesaria para que se cumpla (2.60) es que el modelo incorpore un intercepto. De otro modo no se

podr afirmar que e 0 ya que no habra una ecuacin normal asociada a este trmino.

41

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

Algunas expresiones tambin tiles para calcular el r2 obtenidas mediante reemplazos de

algunas ecuaciones precedentes son las siguientes:

2

xi2 2 xi2

1

2

yi

yi2

12

Var ( X )

12

Var (Y )

x i yi 2

xi2 yi2

As, el coeficiente de determinacin se interpreta como la proporcin de la variacin total de

Y que la regresin es capaz de explicar. En otras palabras, el r2 mide la efectividad que poseen

las variables independientes X para explicar la variacin que la variable dependiente

experimenta a lo largo de la muestra. Por lo tanto, cuando r2 es muy cercano a 1 se dice que el

modelo de regresin es capaz de explicar un alto porcentaje de las variaciones que registra la

variable explicada. Por lo tanto, el ajuste de la lnea de regresin obtenida por MCO es bastante

bueno, en el sentido que los valores estimados de Y son casi idnticos a los observados y que los

residuos son muy pequeos.

Existen algunos casos en los que el coeficiente de determinacin no es una medida confiable,

por ello se debe tener cuidado al interpretarlo. Por ejemplo, si el nmero de observaciones es

reducido, quiz algn residuo alto puede hacer que el r2 sea insignificante y por tanto se

concluya que la regresin es mala, aunque en realidad el ajuste sea bueno. Otro caso es cuando

las observaciones de X e Y provienen de muestras de series temporales con tendencia similar.

En tal situacin, sucede que el coeficiente de determinacin es cercano a uno, pues las

variaciones que experimenta la variable dependiente son muy similares a las de la variable

independiente, y en consecuencia: yi2 yi2 . Basta con eliminar la tendencia para que el

resultado sea diferente, obtenindose un coeficiente de determinacin menor. En este caso, la

regresin recibe el nombre de esprea o ficticia, pues el modelo estimado en realidad no recoge

la existencia de una relacin de la variable dependiente y los regresores. Esto ocurre cuando las

series de tiempo involucradas presentan ciertas caractersticas que distorsionan la distribucin

del error sobre la base de la cual se construyen las pruebas de inferencia.

La descomposicin de la variacin de Y, sobre la base de la cual se construye el r2, puede

ilustrarse de la siguiente manera:

Yi

ei = Debido al residuo

Yi 0 1 X i

Total= (Yi Y )

Yi

(Yi Y ) = Debido a la regresin

42

Econometra Moderna

MCO: El Modelo de Regresin Bivariado

Xi

Figura 2.2

La variacin de la variable endgena es la suma de dos componentes

La figura 2.2 ilustra lo que hemos derivado de manera matemtica. La lnea continua sobre el

eje horizontal refleja el valor promedio de la variable dependiente Y. El trmino Yi refleja una

observacin de la misma variable. La distancia vertical entre este punto y la lnea del promedio

nos muestra la desviacin total de Yi con respecto a su media (lo que equivale a la suma total de

cuadrados si tomamos en cuenta a todas las observaciones). Como vemos esta distancia vertical

la podemos descomponer en dos partes. La primera de ellas est relacionada con el segmento

que parte de la lnea de regresin estimada y va hasta la lnea del promedio (Yi Y ) . Esta es

la desviacin explicada por la regresin. El segmento restante representa aquella parte que no

es explicada por la regresin y por tanto se relaciona con el residuo ( Yi Yi ).

2.6.2

Propiedades del coeficiente de determinacin

1. Es un nmero no negativo. Para demostrarlo basta recordar que ste simboliza el cociente

entre dos sumas de cuadrados. Sin embargo, se debe advertir que en los casos en los que no

se especifique un intercepto en el modelo, el r2 podra resultar negativo y por tanto no

debera tomarse en consideracin10. Por ello, es preciso hallar el coeficiente de

determinacin ajustado o corregido, el cul se estudiar en el siguiente captulo.

2. Puede tomar valores entre cero y uno, (0 r 2 1) Qu pasara si r 2 fuese cero? No

existira ninguna relacin entre la variable endgena y la explicativa y, por tanto, el

) sera igual a cero y se obtendra

estimador de la pendiente de la variable explicativa (

1

una la lnea de regresin horizontal al eje X.

3. No tiene unidades de medida. Recurdese que es una proporcin, siendo, por tanto, un

nmero puro.

2.7 A MODO DE CONCLUSIN:

En este captulo hemos obtenido el estimador MCO para el modelo lineal simple. Este modelo

considera slo una variable explicativa aparte del intercepto. El estimador MCO cumple con

una serie de propiedades deseables como el insesgamiento y la eficiencia lo que asegura que es

el mejor estimador lineal insesgado en el sentido que los estimados obtenidos tendrn la menor

incertidumbre asociados a ellos.

Dentro del largo camino que an nos queda por recorrer en la exploracin de las aplicaciones

del estimador MCO, este ha sido un paso importante porque nos ha permitido comprender la

lgica a partir del cual se deriva el estimador. Hasta aqu la herramienta ms utilizada han sido

las sumatorias. Sin embargo, un enfoque ms completo se basa principalmente en el anlisis

matricial que es el que empezaremos a utilizar en los captulos siguientes. Para ello se

recomienda que el lector haga un repaso de las principales propiedades de matrices y vectores

as como la interpretacin de las distintas operaciones con los mismos.

10

Recurdese que slo s se incluye un intercepto se cumple que STC = SEC + SRC.

43

You might also like

- Logun - La Comunidad de Seduccion Es Una MierdaDocument65 pagesLogun - La Comunidad de Seduccion Es Una Mierdajorge_ortiz_79100% (10)

- Papeles de Trabajo (Caso Practico)Document16 pagesPapeles de Trabajo (Caso Practico)FREDPEZ100% (2)

- Tareas de Informatica PrimariaDocument61 pagesTareas de Informatica PrimariaAdriana Córdova RamosNo ratings yet

- Guía 1 ElectrostáticaDocument9 pagesGuía 1 ElectrostáticaJavier AlvarezNo ratings yet

- Lubricación de ChumacerasDocument35 pagesLubricación de ChumacerasRamón RocaNo ratings yet

- Redes de Distribucion de Agua Potable en Zonas UrbanasDocument13 pagesRedes de Distribucion de Agua Potable en Zonas UrbanasJulio PerezNo ratings yet

- Energias RenovablesDocument3 pagesEnergias RenovablesJulio PerezNo ratings yet

- Linea de ConduccionDocument11 pagesLinea de ConduccionJulio PerezNo ratings yet

- Hidro 9Document4 pagesHidro 9Julio PerezNo ratings yet

- Sediment oDocument23 pagesSediment oJulio PerezNo ratings yet

- TurismoDocument14 pagesTurismoJulio PerezNo ratings yet

- Proyecto Explotacion de PozoDocument40 pagesProyecto Explotacion de PozoJulio PerezNo ratings yet

- Energias RenovablesDocument3 pagesEnergias RenovablesJulio PerezNo ratings yet

- Manual Del HormigonDocument43 pagesManual Del HormigonAna Escoto100% (1)

- Manual Del HormigonDocument43 pagesManual Del HormigonAna Escoto100% (1)

- Calculo AplicDocument18 pagesCalculo AplicJulio PerezNo ratings yet

- Econometria de Series de Tiempo 1 FinalDocument22 pagesEconometria de Series de Tiempo 1 FinalJulio PerezNo ratings yet

- Ingenieria CivilDocument3 pagesIngenieria CivilAurelio Quispe TtitoNo ratings yet

- Ensayo 6 Peso Unitario de AgregadosDocument9 pagesEnsayo 6 Peso Unitario de AgregadosJulio PerezNo ratings yet

- Ensayo 7Document5 pagesEnsayo 7Julio PerezNo ratings yet

- Informe sobre retraso en envío de documentación para reembolso de Bomberos del CuscoDocument1 pageInforme sobre retraso en envío de documentación para reembolso de Bomberos del CuscoJulio PerezNo ratings yet

- MetodologiaDocument12 pagesMetodologiaJulio PerezNo ratings yet

- Ensayo 7Document5 pagesEnsayo 7Julio PerezNo ratings yet

- La Economia MixtaDocument27 pagesLa Economia MixtaJulio PerezNo ratings yet

- Palabra ReservadaDocument4 pagesPalabra ReservadaMichael Romero HerreraNo ratings yet

- Plantilla WISC IVDocument3 pagesPlantilla WISC IVMarilyn L. Chávez IllescasNo ratings yet

- Problemas3 2MCUDocument2 pagesProblemas3 2MCUMarcosTournoudNo ratings yet

- Monitorización Cardiaca Definición Y Objetivo Enfermería en Cuidados Críticos Pediátricos y Neonatales 2Document1 pageMonitorización Cardiaca Definición Y Objetivo Enfermería en Cuidados Críticos Pediátricos y Neonatales 2Maygualidia AguilarNo ratings yet

- MWD - y - LWD (1) EsteDocument9 pagesMWD - y - LWD (1) EsteAlberta CostanaNo ratings yet

- Robles Luis Tarea3Document9 pagesRobles Luis Tarea3Luis RoblesNo ratings yet

- GUÍA #1 DE MATEMATICAS 2do PeriodoDocument16 pagesGUÍA #1 DE MATEMATICAS 2do PeriodoRaúl edgardo Cardona lafaurieNo ratings yet

- Programación Visual: DR Juan Carlos López PimentelDocument9 pagesProgramación Visual: DR Juan Carlos López PimentelFer TorresNo ratings yet

- Problemas de Progresiones Aritmeticas y GeometricasDocument3 pagesProblemas de Progresiones Aritmeticas y Geometricastheundertaker00100% (1)

- TEMA4 FilosofiaDocument13 pagesTEMA4 FilosofiaIno YamanakaNo ratings yet

- Transformadores: Comportamiento y pruebas básicasDocument15 pagesTransformadores: Comportamiento y pruebas básicasAlejandro SepúlvedaNo ratings yet

- CM Semana 1Document3 pagesCM Semana 1ClaudioMurúaNo ratings yet

- GUIA REACCIONES QUIMICAS ESTEQIOMETRA 11 - 1 y 11-2 TERESIANO AÑO ELECTIVO 2020.Document3 pagesGUIA REACCIONES QUIMICAS ESTEQIOMETRA 11 - 1 y 11-2 TERESIANO AÑO ELECTIVO 2020.Santiago Salazar LópezNo ratings yet

- HistoriadelOrdenador PrimerFinalDocument11 pagesHistoriadelOrdenador PrimerFinaldvfsdssssNo ratings yet

- Definicion de Hardware y SoftwareDocument3 pagesDefinicion de Hardware y Softwaregeorgeinfo6No ratings yet

- SEP Introduccion 2015Document24 pagesSEP Introduccion 2015Charlie IsraelNo ratings yet

- Taller de RepasoDocument4 pagesTaller de RepasoJuan Camilo BelalcazarNo ratings yet

- Mate Exp 2 Act 3Document5 pagesMate Exp 2 Act 3Yuly Alejandra Andrade ChoquehuancaNo ratings yet

- Sistemas de coordenadas generalizadas en análisis estructuralDocument5 pagesSistemas de coordenadas generalizadas en análisis estructuralJhon Briones100% (1)

- INFORME N°3: PLANOS CRISTALOGRAFICOS / Laboratorio de CristalografiaDocument26 pagesINFORME N°3: PLANOS CRISTALOGRAFICOS / Laboratorio de CristalografiaRonald Richard Quiliche GalvezNo ratings yet

- Conjugación de VerbosDocument4 pagesConjugación de VerbosluisNo ratings yet

- 178-179 TSP1 2024 1Document3 pages178-179 TSP1 2024 1ruben dario guerra chirinosNo ratings yet

- Zonas geoastronómicas tierra ciencias 5toDocument2 pagesZonas geoastronómicas tierra ciencias 5tovaleria risquezNo ratings yet

- Comandos Configuracion VPN Server Packet TracerDocument3 pagesComandos Configuracion VPN Server Packet TracerMarcelo SantosNo ratings yet

- Pre-Requisitos MVCDocument19 pagesPre-Requisitos MVCJorge GarciaNo ratings yet

- E Práctica#2Document10 pagesE Práctica#2Sofia Coppiano GarciaNo ratings yet

- Foro Semana 5 y 6 - PROGRAMACION DE COMPUTADORESDocument4 pagesForo Semana 5 y 6 - PROGRAMACION DE COMPUTADORESjuan estebanNo ratings yet