Professional Documents

Culture Documents

Méthodes de Monte Carlo Pour La Finance

Uploaded by

Rajita EconomisteOriginal Title

Copyright

Available Formats

Share this document

Did you find this document useful?

Is this content inappropriate?

Report this DocumentCopyright:

Available Formats

Méthodes de Monte Carlo Pour La Finance

Uploaded by

Rajita EconomisteCopyright:

Available Formats

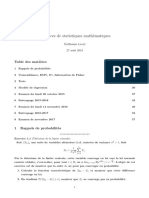

Methodes de Monte Carlo pour la nance

DEA Statistiques et Mod`eles Aleatoires en

Economie et

Finance

Universite Paris VII

Emmanuel TEMAM

Universite Paris VII, LPMA

temam@math.jussieu.fr

Avril 2004

2

Table des mati`eres

1 Introduction 5

1.1 Presentation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

1.2 Rappels sur les methodes de Monte Carlo . . . . . . . . . . . . . . . . . . . . 6

1.3 Notations . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

2 Schemas dapproximation dEDS 9

2.1 Simulation du mouvement Brownien et des processus rattaches . . . . . . . . 9

2.1.1 Simulation du mod`ele de Black Scholes . . . . . . . . . . . . . . . . . 9

2.1.2 Une construction du mouvement Brownien . . . . . . . . . . . . . . . 10

2.2 Discretisation dEDS . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

2.2.1 Le schema dEuler . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

2.2.2 Le schema de Milshtein . . . . . . . . . . . . . . . . . . . . . . . . . . 13

2.2.3 Schemas dordre superieur . . . . . . . . . . . . . . . . . . . . . . . . . 16

2.3 Methodes speciales pour les options exotiques . . . . . . . . . . . . . . . . . . 17

2.3.1 Options asiatiques . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

2.3.2 Options sur maximum . . . . . . . . . . . . . . . . . . . . . . . . . . . 21

2.3.3 Options barri`eres . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 24

3 Reduction de variance 29

3.1 Fonctions dimportance . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

3.1.1 Un exemple en nance . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

3.1.2 Generalites . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

3.1.3 Theor`eme de Girsanov et fonctions dimportance pour les diusions . 31

3.2 Variables antithetiques . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

3.3 Variables de contr oles . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34

3.3.1 Theorie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 34

3.3.2 Exemples . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

3.3.3 Valeur moyenne et conditionnement . . . . . . . . . . . . . . . . . . . 38

4 Calcul des sensibilites 41

4.1 Rappels sur les sensibilites . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 41

4.2 Approche par dierences nies . . . . . . . . . . . . . . . . . . . . . . . . . . 42

4.3 Amelioration des techniques pour Monte Carlo . . . . . . . . . . . . . . . . . 42

4.3.1 Notion de processus tangent . . . . . . . . . . . . . . . . . . . . . . . . 42

4.3.2 Applications aux calculs de couverture . . . . . . . . . . . . . . . . . . 44

4.4 Calcul de Malliavin . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 46

3

4 TABLE DES MATI

`

ERES

4.4.1 Introduction au calcul de Malliavin . . . . . . . . . . . . . . . . . . . . 47

4.4.2 Applications aux calculs des sensibilites . . . . . . . . . . . . . . . . . 51

5 Les options americaines 55

5.1 Introduction . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 55

5.2 Lalgorithme de Longsta Schwartz . . . . . . . . . . . . . . . . . . . . . . . . 57

5.2.1 Une equation de programmation dynamique pour

. . . . . . . . . . 57

5.2.2 La methode de regression . . . . . . . . . . . . . . . . . . . . . . . . . 57

5.2.3 Du Monte Carlo pour le probl`eme de regression . . . . . . . . . . . . . 58

5.3 Approximation desperances conditionnelles . . . . . . . . . . . . . . . . . . . 59

5.3.1 Calcul de Malliavin : complements . . . . . . . . . . . . . . . . . . . . 60

5.4 Application `a levaluation doptions americaines . . . . . . . . . . . . . . . . . 67

Chapitre 1

Introduction

1.1 Presentation

Dans un mod`ele stochastique, les prix des actifs sont representes comme la solution dune

equation dierentielle stochastique. Le probl`eme essentiel pose les mathematiques nanci`eres

est devaluer les produits derives sur ces actifs.

Dans la plupart des cas, le payo de ces produits est donne par une fonction de lactif sous-

jacent `a une (ou des) date(s) future(s). Le prix, dans un mod`ele complet, est alors lesperance

sous lunique probabilite risque neutre du payo actualise. Linteret numerique est donc de

calculer cette esperance de la mani`ere la plus ecace et la plus rapide possible.

Il existe de nombreux types de methodes pour cela :

Ces esperances peuvent `a laide de la formule de Feynman-Kac secrire comme la solutions

dequations aux derivees partielles. Ainsi, on peut utiliser les methodes existantes de type

elements nis ou dierences nies.

Il existe egalement les methodes dites darbre, qui consistent ` a approcher la solution de

lequation dierentielle stochastique par une chane de Markov discr`ete.

Enn, les methodes de Monte Carlo sur lesquelles nous nous concentrerons. Ces methodes

necessitent de savoir simuler lEDS du sous-jacent. Souvent, il faut recourir ` a des schemas

numeriques, ce sera lobjet du chapitre 1. De plus, meme cette discretisation eectuee, il

peut saverer que la methode ne soit pas ecace, par exemple lorsque la variance est trop

elevee. Les methodes de reduction de variance permettent deviter ce genre de diculte

(voir chapitre 2).

La nance pose dautres probl`emes nettement plus ardus et qui sont encore aujourdhui lobjet

de developpement constant :

levaluation du prix nest pas le plus important et meme un prix ne sert ` a rien si on ne

donne pas une strategie. Levaluation des grecques (les derivees du prix par rapport au

point initial ou `a la volatilite) est un probl`eme complexe du au fait quil sagit dune

dierentielle (voir chapitre 3).

En fait, sur le marche, on ne dispose pas de volatilite. Il faut evaluer les param`etres du

mod`ele `a laide de prix de certaines options tellement liquides quelles sont cotees directe-

ment. Ce type de probl`eme sappelle la calibration.

Enn, il existe des options qui peuvent etre exercees ` a nimporte quel instant. Ce sont les

options americaines et leurs evaluations posent des probl`emes plus complexes (voir chapitre

5

6 CHAPITRE 1. INTRODUCTION

4).

1.2 Rappels sur les methodes de Monte Carlo

Les methodes de Monte Carlo sont nees gr ace ` a Louis Buon mathematicien du XV II

eme

si`ecle. Il a prouve que si lon se donne un parquet dont les lattes sont ecartees dune longueur

d, et que lon jette toujours de la meme hauteur une aiguille de longueur l la probabilite

que laiguille touche deux stries est de ????. Il a ainsi entrevu une possibilite pour calculer le

nombre numeriquement. En eet, en lan cant un grand nombre daiguilles et en comptant

celles qui touchaient deux stries il detenait une valeur approximative de la probabilite. Cette

experience repose sur un theor`eme : la loi forte des grands nombres.

Theor`eme 1.1 (Loi forte des grands nombres). Soit (X

i

, i 1) une suite de variables

aleatoires independantes et identiquement distribuees (i.i.d.) telles que E ([X

1

[) < +, alors

lim

n+

_

1

n

n

i=1

X

i

_

= E(X

1

) .

Ce theor`eme permet dutiliser des algorithmes probabilistes pour calculer nimporte quelle

esperance. Considerons le cas o` u les variables aleatoires suivent une loi uniforme sur [0, 1].

Alors un generateur aleatoire permet de simuler cette loi. Pour approcher son esperance, il

sut donc de simuler n fois cette loi et de faire la moyenne des simulations. Cest aussi pour

cela que le terme de gauche est souvent appele moyenne arithmetique et on le notera

X

n

Il faut remarquer egalement que cette methode permet de calculer un certain nombre dinteg-

rales. Soit I =

_

1

0

f(u)du o` u f est une fonction integrable. On voit immediatement que I se

reecrit comme I = E[(f(U))] o` u U est une variable aleatoire de loi |

[0,1]

. En appliquant

lalgorithme precedant `a X

i

= f(U

i

) on calcule I.

Le probl`eme se pose maintenant devaluer theoriquement lecacite de cette methode. Il

existe des theor`emes qui permettent de calculer la vitesse de convergence dune methode de

Monte Carlo.

Theor`eme 1.2 (Theor`eme de la Limite Centrale). Soit (X

i

, i 1) une suite de variables

aleatoires, independantes et identiquement distribuees telles que E(X

2

i

) < +. On pose

2

=

Var(X

2

i

), alors

2

_

E[(X

1

)]

1

n

(X

1

+. . . +X

n

)

_

L

G o` u G ^(0, 1).

Remarque 1.1. Contrairement aux methodes non probabilistes, la methode de Monte Car-

lo, utilisee pour calculer des integrales, ne necessite pas de fonctions reguli`eres.

Lerreur que donne le Theor`eme de la Limite Centrale nest pas bornee car le support de

la gaussienne est R.

De ce theor`eme on peut deduire des intervalles de conance qui sont des indicateurs im-

portants de la performance dune methode de Monte Carlo.

Il faut egalement noter que levaluation de la variance est cruciale pour mesurer lecacite

de la methode. En eet, en supposant que celle-ci nest pas aleatoire, on peut reecrire le

1.3. NOTATIONS 7

theor`eme de la limite centrale comme :

n

_

E[(X

1

)]

1

n

(X

1

+. . . +X

n

)

_

L

G o` u G ^(0,

2

).

Ainsi, si on veut construire des intervalles de conance, leurs largeurs depend du nombre de

simulations et de la variance. Pour resume, lecacite des methodes de Monte Carlo secrit

n

.

Pour evaluer la variance, on dispose destimateurs. Soit (X

1

, . . . , X

n

), une suite de variables

aleatoires veriant les hypoth`eses du theor`eme de la limite centrale. Lestimateur standard

de la variance est :

n

2

=

1

n

n

i=1

(X

i

X

n

)

2

.

Cet estimateur est construit par la loi forte des grands nombres. En eet, Var(X) = E

_

X

2

(E[X])

2

. En approchant, les deux esperances par leurs moyennes arithmetiques on retombe

sur

n

. Cependant, on peut montrer que cette estimateur est biaise E

_

n

2

_

=

n

n1

Var(X).

Lestimateur sans biais est donc :

2

n

=

1

n 1

n

i=1

(X

i

X

n

)

2

.

Pour plus de details sur les methodes de Monte Carlo on pourra consulter [40, 44]. Par ailleurs,

nous aurons besoin dun theor`eme qui lie les methodes probabilistes et analytiques :

Theor`eme 1.3. (i) Supposons que b et a sont lipschitziennes et quil existe une solution u

C

1,2

p

` a lequation parabolique

0 =

u

t

+

d

j=1

b

j

u

x

j

+

1

2

d

i,j=1

(aa

)

ij

2

u

x

i

x

j

, sur [0, T] R

d

g = u(T, ) sur R

d

, (1.1)

alors

u(t, x) = E[g(X

T

)[X

t

= x] et g(X

T

) = E[g(X

T

)] +

_

T

0

x

u(t, X

t

)a(X

t

)dW

t

. (1.2)

(ii) Si a C

4

b

, b C

2

b

et g C

4

p

, alors la reciproque est vraie et u C

4

p

.

1.3 Notations

Dans la suite on notera S

t

la solution de lequation dierentielle stochastique, X

t

la solution

dune equation dierentielle stochastique generale.

8 CHAPITRE 1. INTRODUCTION

On commence par introduire quelques notations. On identiera un element x de R

d

au vecteur

colonne associe de coordonnees x

j

, j = 1, . . . , d. On notera I

d

la matrice identite de M

d

et e

d

le vecteur unite de R

d

. La norme euclidienne sur R

d

ou M

d

sera notee ||. Pour un element a

de M

d

, on notera a

i

le vecteur ligne correspondant ` a sa i-`eme ligne et a

j

le vecteur colonne

correspondant `a sa j-`eme colonne. La transposee de a M

d

sera notee a

. Pour un ensemble

de point (x

i

)

d

i=1

, on notera Vect[(x

i

)

d

i=1

] le vecteur colonne de composantes x

i

. Pour x

R

d

, on notera diag [x] la matrice diagonale de M

d

dont les elements diagonaux sont les x

i

.

Pour une fonction f : R

d

R

n

, on notera f sa matrice Jacobienne, i.e. (f)

ij

= f

i

/x

j

.

Si f : (R

d

)

k

R

n

, on notera

f, la matrice Jacobienne obtenue en derivant par rapport

`a sa -`eme composante vectorielle, i.e. (

f(x

1

, . . . , x

k

))

ij

= f

i

(x

1

, . . . , x

k

)/x

j

. On ecrira

parfois simplement

x

f. On notera C

k

p

(resp. C

k

b

) lensemble des fonctions C

k

` a croissance

polyn omiale (resp. bornees) dont les derivees sont egalement ` a croissance polyn omiale (resp.

bornees). Lorsque la fonction est seulement denie sur A, on notera C

k

(A), C

k

p

(A) et C

k

b

(A).

^(m, ) designera la loi normale de moyenne m et de matrice de variance-covariance . On

notera souvent par C > 0 une constante generique qui peut changer de valeur dune ligne ` a

lautre.

Chapitre 2

Schemas dapproximation dEDS

Le but de cette partie est de decrire les methodes utilisees pour la simulation trajectorielle

dun processus donne. Cette simulation est necessaire lorsque lon veut calculer une option

dependant de la trajectoire (options asiatiques, barri`eres, etc...) dont le prix peut secrire :

E[f (X

s

, s T)] ,

o` u est la fonctionnelle du processus X.

2.1 Simulation du mouvement Brownien et des processus rat-

taches

Nous commen cons par la simulation du mouvement Brownien. La simulation approximative

dune trajectoire du mouvement Brownien est un algorithme simple. En eet, soit h un

intervalle de discretisation. Soit (G

k

, 0 k N) une realisation dune famille de variables

aleatoires normales de moyenne 0 et de variance 1. Pour obtenir une realisation de (W

ph

, 1

p N), il sut de calculer :

W

h

ph

=

1kp

G

k

.

On peut remarquer que dans ce cas la loi de lapproximation (W

h

ph

, 1 p N) est identique

`a la loi du vecteur (W

ph

, 1 p N) : il ny a donc pas derreur de discretisation.

2.1.1 Simulation du mod`ele de Black Scholes

Soit

S

t

= xexp

__

r

2

2

_

t +W

t

_

.

En utilisant le paragraphe precedent, on construit une simulation exacte en loi du vecteur

(S

ph

, 1 p N) en posant :

S

h

ph

= xexp

__

r

2

2

_

ph +W

h

ph

_

.

9

10 CHAPITRE 2. SCH

EMAS DAPPROXIMATION DEDS

Il faut remarquer que lon peut obtenir une simulation exacte quand la volatilite est une

fonction du temps puisque

_

(p+1)h

ph

s

dW

s

,

reste une suite de variable aleatoire gaussienne de moyenne 0 et de variance

_

(p+1)h

ph

2

s

ds.

2.1.2 Une construction du mouvement Brownien

Dans certains cas nous avons besoin dune methode de simulation qui peut etre ranee en

certains points de la trajectoire. Cela est une des caracteristiques de la methode suivante. Il

faut noter que cet algorithme donne aussi une construction dune trajectoire du mouvement

Brownien.

Cette simulation repose sur le calcul de la loi conditionnelle de Wt+s

2

sachant W

s

et W

t

. Si

s t, le vecteur (W

s

, Wt+s

2

, W

t

) est un vecteur gaussien. On peut donc trouver deux nombres

et tels que la variable aleatoire Z

,

denie par

Z

,

= Wt+s

2

W

s

W

t

,

soit independante de (W

s

, W

t

). Le vecteur (Z

,

, W

s

, W

t

) est encore un vecteur gaussien de

moyenne nulle. Donc, Z

,

est independante de W

s

et de W

t

si et seulement si

Cov(Z

,

, W

s

) = 0 et Cov(Z

,

, W

t

) = 0.

Comme

Cov(Z

,

, W

s

) = E

_

Ws+t

2

W

s

_

E(W

2

s

) E(W

2

t

),

et que t et s

E(W

s

W

t

) = t s = inf(s, t),

on obtient

Cov(Z

,

, W

s

) = s s s,

et :

Cov(Z

,

, W

s

) =

s + t

2

s t.

Il est clair que les deux covariances sannulent si et seulement si = = 1/2. De plus,

comme Z

,

est une combinaison lineaire delements dun vecteur gaussien, cest une variable

gaussienne. Pour determiner enti`erement sa loi, il sut de calculer sa moyenne et sa variance.

Si Z = Z

1/2,1/2

alors

Z = Xt+s

2

1

2

(W

s

+W

t

).

Ainsi E(Z) = 0 et

Var(Z) = E(Z

2

) = E

_

_

Ws+t

2

s +t

2

(W

s

+W

t

)

_

2

_

=

t +s

2

+

t

4

+

s

4

t +s

2

s +

s

2

=

1

4

(t s). (2.1)

2.2. DISCR

ETISATION DEDS 11

Z peut donc secrire :

Z =

1

2

t sG

t,s

,

o` u G

t,s

est une variable aleatoire gaussienne de moyenne nulle et de variance 1, independante

de (W

s

, W

t

).

Remarque 2.1. On peut montrer que G

t,s

est independante de (W

u

, u s) et (W

u

, u t).

On peut resumer ce raisonnement comme suit :

_

Wt+s

2

=

1

2

(W

t

+W

s

) +

1

2

t sG

t,s

G

t,s

est independant de (W

u

, u s) et (W

u

, u t),

(2.2)

Cela permet denvisager une procedure de simulation (ou de construction) de la trajectoire

de (X

s

, 0 s 1)

1. Calculer X

1

avec une variable ^(0, 1),

2. Utiliser 2.2, avec s = 0 et t = 1 pour simuler X

1/2

,

3. Utiliser 2.2, avec s = 0 et t = 1/2 pour simuler X

1/4

,

4. Utiliser 2.2, avec s = 1/2 et t = 1 pour simuler X

3/4

,

5. et ainsi de suite !

Cette methode peut etre utile pour calculer les chemins du processus de Wiener sur des

meshs dont la taille se reduit de plus en plus.

2.2 Discretisation dEDS

La methode de Monte Carlo utilisee pour approcher E[f(X

T

)] suppose que lon sait simuler

la loi de la variable aleatoire X

T

. Or, en general, on ne peut pas resoudre explicitement

lequation dierentielle stochastique associee au processus X. Par exemple, la plupart des

mod`eles de taux dinteret conduisent ` a des equations qui nont pas de solutions explicites.

De plus, meme si on trouve une solution, celle-ci peut etre trop complexe pour etre simulee

directement. Ainsi, par analogie avec les EDP, il est naturel de chercher ` a simuler une solution

`a partir de lequation elle-meme en utilisant des schemas dapproximation. Ainsi, la methode

de Monte Carlo va consister en lapproximation de E[f(X

T

)] par

i

f(

X

n

t

) o` u

X

n

est le

schema. Lerreur de ces methodes a deux causes : une erreur statistique et une erreur liee ` a

la discretisation.

2.2.1 Le schema dEuler

Notre but est de trouver un schema approchant la solution dune equation dierentielle sto-

chastique. Soit (X

t

, t 0) le processus d-dimensionnel solution de

X

t

= X

0

+

_

t

0

b(X

s

)ds +

_

t

0

(X

s

)dW

s

, (2.3)

o` u (W

t

, t 0) est un mouvement Brownien r-dimensionnel.

12 CHAPITRE 2. SCH

EMAS DAPPROXIMATION DEDS

Le schema le plus simple est celui dEuler. Soit n le nombre dintervalles de discretisation

choisi et h = T/n. La solution exacte verie :

X

h

= X

0

+

_

h

0

b(X

s

)ds +

_

h

0

(X

s

)dW

s

.

En se fondant sur la denition dun processus dIt o, une approximation naturelle est X

h

denie par :

X

h

X

0

+b(X

0

)h +(X

0

)(W

h

W

0

).

En procedant par recurrence, on obtient le schema dEuler pour lequation dierentielle sto-

chastique (2.3) :

X

n

0

= X

0

,

X

n

t

k+1

=

X

n

t

k

+b(

X

n

t

k

)h +(

X

n

t

k

)(W

t

k+1

W

t

k

).

(2.4)

Comme lon est en dimension superieur ` a 1, il faut faire attention aux produits matriciels :

X

n

0

= X

0

,

X

n,i

t

k+1

=

X

n,i

t

k

+b

i

(

X

n

t

k

)h +

r

j=1

i,j

(

X

n

t

k

)(W

j

t

k+1

W

j

t

k

) 1 i d

(2.5)

Ce schema est une generalisation naturelle aux EDS des schemas dEuler utilises pour les

equations dierentielles ordinaires. La simulation dun schema dEuler est extremement simple

puisquil sut de simuler la variable gaussienne W

h

W

0

= W

h

.

Le theor`eme suivant donne les resultats de convergence connus pour le schema dEuler. Nous

renvoyons au polycopie sur les methodes de Monte Carlo pour les demonstrations (voir aussi

[22, 23, 55]).

Theor`eme 2.1. Soient b et deux fonctions lipschitziennes. Soit (W

t

, t 0) un mouvement

Brownien r-dimensionnel. On note (X

t

, t 0) lunique solution de

dX

t

= b(X

t

)dt +(X

t

)dW

t

, X

0

= x,

et par (

X

n

kh

, k 0) la suite de variables aleatoires denies par lequation (2.4). Alors, pour

tous q 1 :

Convergence forte :

E

_

sup

k,khT

X

n

kh

X

kh

2q

_

Ch

q

.

De plus, pour tous < 1/2, presque s urement

lim

h0

h

sup

k,khT

X

n

kh

X

kh

= 0,

2.2. DISCR

ETISATION DEDS 13

Convergence faible : Si b et sont des fonctions C

4

avec des derivees bornees jusqu` a

lordre 4 et f est une fonction C

4

` a croissance polyn omiale avec des derivees bornees jusqu` a

lordre 4 si h = T/N, alors il existe une constante C

T

telle que

E(f(X

T

)) E

_

f(

X

n

T

)

_

C

T

(f)

N

.

Remarque 2.2. Ce theor`eme prouve que la vitesse de convergence dans L

2

est de lordre

de h

1/2

et que la vitesse de convergence presque sure est dordre h

1/2

, pour tout > 0. Le

deuxi`eme resultat montre que pour des fonctions reguli`eres, la vitesse de convergence en loi

du schema est dordre h.

2.2.2 Le schema de Milshtein

Pour les equations dierentielles ordinaires, le schema dEuler peut etre ameliore par les

methodes de Runge Kutta. Plusieurs schemas dordre superieur ont ete proposes pour les

EDS. Nous verrons cependant que leur mise en oeuvre reste delicate.

Le plus simple schema dordre 2 est le schema de Milshtein. Il permet de faire converger ` a

une vitesse superieure dans les espaces L

p

mais est dicile ` a simuler quand la dimension est

strictement plus grande que 1 et converge en loi ` a la meme vitesse que le schema dEuler.

Cas de la dimension 1

Nous commen cons par construire le schema de Milshtein quand d = r = 1. Ce schema est

deni par

X

n

0

= x et pour k 1 :

X

n

((k + 1)h) =

X

n

kh

+b

_

X

n

kh

_

h +

_

X

n

kh

_

_

W

(k+1)h

W

kh

_

+

X

n

kh

)(

X

n

kh

)

_

(k+1)h

kh

(W

s

W

kh

) dW

s

.

(2.6)

Remarque 2.3. Il est facile de comprendre comment le nouveau terme apparat en regardant

lequation

dX

t

= (X

t

)dW

t

.

On peut etendre le schema dEuler ` a tous t dans [t

k

, t

k+1

] par interpolation lineaire. Si t

k

= kh

X

n

t

=

X

n

t

k

+

_

X

n

t

k

_

(W

t

W

t

k

) .

X

n

t

donne une approximation de X

t

sur lintervalle [t

k

, t

k+1

] qui est meilleure que

X

n

(t

k

).

On peut esperer que (

X

n

t

) est une meilleure approximation de (X

t

) que (

X

n

t

k

).

Un bon candidat pour un schema dordre superieur est

X

n

t

=

X

n

t

k

+

_

t

t

k

X

n

s

_

dW

s

.

Ce schema peut etre approche en utilisant des developpements de Taylor

X

n

t

_

=

_

X

n

t

k

+

_

X

n

t

k

_

(W

t

W

t

k

)

_

_

X

n

t

k

_

+

X

n

t

k

_

X

n

t

k

_

(W

t

W

t

k

) .

14 CHAPITRE 2. SCH

EMAS DAPPROXIMATION DEDS

Cela conduit au schema suivant

X

n

t

=

X

n

t

k

+

_

X

n

t

k

_

(W

t

W

t

k

) +

_

X

n

t

k

_

X

n

t

k

_

_

t

t

k

(W

t

W

t

k

) dW

s

.

Nous avons retrouve le schema de Milshtein quand b = 0. Les calculs precedents setendent

au cas o` u b ,= 0.

Dun point de vue pratique il est important de noter que par la formule dIt o :

_

(k+1)h

kh

(W

s

W

kh

) dW

s

=

1

2

_

_

W

(k+1)h

W

kh

_

2

h

_

.

Le schema de Milshtein se reecrit donc :

X

n

(k+1)h

=

X

n

kh

+

_

b

_

X

n

kh

_

1

2

X

n

kh

)(

X

n

kh

)

_

h +

_

X

n

kh

_

_

W

(k+1)h

W

kh

_

+

1

2

X

n

kh

)(

X

n

kh

)

_

W

(k+1)h

W

kh

_

2

.

Ce schema est facile `a mettre en oeuvre car les variables aleatoires (W

(k+1)h

W

kh

, k 0)

sont impliquees.

Exemple 2.1. Considerons le cas o` u (S

t

, t 0) est une diusion log-normale denie par :

dS

t

= S

t

(rdt +dW

t

) , S

0

= x.

Soit W

k

= W

(k+1)h

W

kh

. Le schema dEuler secrit

X

n

(k+1)h

=

X

n

kh

(1 +rh +W

k

) ,

et le schema de Milshtein

X

n

(k+1)h

=

X

n

kh

_

1 +

_

r

1

2

2

_

h +W

k

+

1

2

2

(W

k

)

2

_

.

Le schema de Milshtein en dimension superieure Quand le nombre r de mouvements

Brownien impliques dans lequation dierentielle stochastique est plus grand que 1, le schema

de Milshtein secrit comme

X

n

(k+1)h

=

X

n

kh

+b

_

X

n

kh

_

h +

_

X

n

kh

_

_

W

(k+1)h

W

kh

_

+

p

j,l=1

(

j

l

) (

X

n

kh

)

_

(k+1)h

kh

_

W

j

s

W

j

kh

_

dW

l

s

,

(2.7)

avec, pour 1 i n

(

j

l

)

i

(x) =

n

r=1

ij

(x)

x

r

rl

(x).

Ces formules sobtiennent de la formule de Taylor comme ` a lordre 1.

2.2. DISCR

ETISATION DEDS 15

Remarque 2.4. Le schema de Milshtein est dicile ` a implementer car lon doit simuler le

vecteur

_

W

j

(k+1)h

W

j

kh

,

_

(k+1)h

kh

_

W

j

s

W

j

kh

_

dW

l

s

_

,

pour 1 j p, 1 l p. Il est facile de voir que la simulation de

_

(k+1)h

kh

_

W

j

s

W

j

kh

_

dW

l

s

,

ne peut faire intervenir que W

(k+1)h

W

kh

. Il nexiste pas ` a ce jour de methode ecace pour

la simulation de ces lois.

Quand p = 2, il est equivalent de simuler

_

W

1

h

, W

2

h

,

_

h

0

W

1

s

dW

2

s

W

2

s

dW

1

s

_

,

et la methode decrite dans [26] est compliquee.

Le schema de Milshtein peut etre utilise facilement quand il nest pas necessaire de simuler

_

h

0

W

1

s

dW

2

s

W

2

s

dW

1

s

. Cest le cas en dimension 1 ou quand la condition de commutativite

suivante est satisfaite

(C) Pour tous j, k dans 1, . . . , p et pour tous x R

n

:

j

(x)

k

(x) =

k

(x)

j

(x).

Sous lhypoth`ese (C), on peut reecrire le schema de Milshtein comme

X

n

(k+1)h

=

X

n

kh

+

_

_

b

_

X

n

kh

_

1

2

p

j=1

(

j

j

)(

X

n

kh

)

_

_

h +

_

X

n

kh

_

_

W

(k+1)h

W

kh

_

+

1

2

p

j,l=1

(

j

l

) (

X

n

kh

)

_

W

j

(k+1)h

W

j

kh

__

W

l

(k+1)h

W

l

kh

_

.

On a alors seulement besoin de

_

(W

j

(k+1)h

W

j

kh

), k 0, 1 j p

_

.

Le theor`eme suivant donne la vitesse de convergence du schema de Milshtein

Theor`eme 2.2. On suppose que b et sont deux fois continuement dierentiables avec des

derivees bornees. On note (X

t

, t 0) lunique solution de

dX

t

= b(X

t

)dt +(X

t

)dW

t

, X

0

= x,

et par (

X

n

kh

, k 0) la suite de variables aleatoires denis par (2.7). Alors

convergence forte :

pour tous q 1, sup

k,khT

E

_

X

kh

X

n

kh

q

_

Ch

q

,

De plus, pour tous < 1, on a

lim

h0

1

h

sup

k,khT

X

kh

X

n

kh

= 0,

16 CHAPITRE 2. SCH

EMAS DAPPROXIMATION DEDS

Convergence en loi : Si b et sont deux fonctions C

4

avec des derivees bornees jusqu` a

lordre 4 et si f est une fonction ` a croissance polyn omiale C

4

avec des derivees bornees

jusqu` a lordre 4, alors il existe une constante C

T

(f) > 0 telle que

E(f(X

T

)) E

_

f(

X

n

T

)

_

C

T

(f)

N

.

Remarque 2.5. Il faut remarquer que ce resultat ne depend pas de lhypoth`ese de commu-

tativite (C).

Le schema de Milshtein ameliore les vitesses de convergence trajectorielles : il est dordre h

alors que le schema dEuler est dordre

h. Neanmoins, la vitesse de convergence pour des

fonctions reguli`eres est la meme. Or cest ce type de convergence qui est important en nance

pour les methodes de Monte Carlo. De plus, le schema de Milshtein necessite la simulation de

termes supplementaires ce qui nuit ` a sa vitesse dexecution. En consequence, dans la plupart

des cas on utilisera le schema dEuler.

2.2.3 Schemas dordre superieur

Nous avons vu quil etait facile dobtenir des vitesses de convergence trajectorielle dordre

h

(schema dEuler) ou dordre h (schema de Milshtein). Il est naturel dessayer de construire

des schemas dordre superieurs. Toutefois, un resultat de Clark and Cameron (see [16] ou [23])

prouve que, vis `a vis de la norme L

2

le schema dEuler est optimal dans la classe des schemas

nutilisant que les variables W

ph

, p 1. Si on accepte dutiliser plus que ces increments on

peut construire des schemas dordre arbitraire (voir [39]). Ces schemas sont tr`es peu utilises

en nance.

Pour tout developpement supplementaire : [56, 39, 23, 22], [36], [55] et [39].

Methodes de Romberg pour Euler et Milshtein Une meilleure mani`ere dameliorer

sensiblement les vitesses de convergence en loi est dutiliser la methode dextrapolation de

Romberg.

Talay and Tubaro [57] et Bally et Talay [6, 7] ont montre que lerreur faible de discretisation,

du schema dEuler en particulier, peut secrire en developpement limite en fraction

1

n

.

Theor`eme 2.3. On suppose que b et sont deux fonctions de classe C

` a derivees bornees.

On suppose de plus que

Soit f est une fonction de classe C

` a derivees ` a croissance polyn omiales.

Soit f est une fonction mesurable bornee, et loperateur satisfait une condition dellipti-

cite :

tel que x R

d

, |(x)

(x)| > .

Alors, pour tous h =

T

n

lerreur en T secrit

Ef(X

T

) Ef

_

X

h

T

_

= C(f)h +O(h

2

).

o` u C(f) est une constante qui peut etre calculee en fonction de f (voir [6, 7] pour une

expression de C(f)).

2.3. M

ETHODES SP

ECIALES POUR LES OPTIONS EXOTIQUES 17

Nous sommes maintenant capable dappliquer lextrapolation de Romberg.

Corollaire 2.4. On suppose les memes hypoth`eses que pour le theor`eme 2.3. Soit

X

n/2

le

schema dEuler avec pas de n/2. Alors

[Ef(X

T

) 2Ef(

X

h

T

) Ef(

X

2h

T

)[ K

T

h

2

.

Ce resultat est une consequence immediate de 2.3. Le co ut numerique de cette methode est

bien plus faible que celui dun schema dordre 2 (voir [57]).

2.3 Methodes speciales pour les options exotiques

Quand le payo dune option est specie on peut construire des methodes plus ecaces.

2.3.1 Options asiatiques

Dans ce paragraphe, on suppose que le payo secrit

f

_

S

T

,

_

T

0

S

s

ds

_

,

o` u f est une fonction bornee et (S

t

, t 0) est la solution de lEDS de Black et Scholes

S

t

= xe

(r

1

2

2

)t+Wt

.

Si on veut utiliser des methodes de Monte Carlo pour calculer le prix dune de ces options,

on doit simuler la moyenne de S

t

, et donc approcher son integrale. Ici, il nest pas necessaire

dapprocher S

t

car il peut etre simule exactement aux instants kh avec h = T/N, et on

notera alors les instants t

k

= kT/N = kh. Nous introduisons trois schemas pour approcher

Y

T

=

_

T

0

S

u

du (voir [41, 58]).

Le schema standard

Comme il est facile de simuler S

t

` a linstant t, lintegrale peut etre approchee par une somme

de Rieman

Y

r,N

T

= h

N1

k=0

S

t

k

. (2.8)

Si M represente le nombre de simulation de Monte Carlo, une approximation du prix dun

call xe asiatique est donnee par

e

rT

M

M

j=1

_

h

T

N1

k=0

S

t

k

K

_

+

.

La complexite de cet algorithme est en O

_

1

NM

_

(cela est vrai quelque soit lalgorithme Monte

Carlo considere) et il comporte deux types derreurs : lerreur de simulation quantie par

lecart type et lerreur due au schema de discretisation en h.

18 CHAPITRE 2. SCH

EMAS DAPPROXIMATION DEDS

Ce schema (2.8) peut etre interprete ` a laide dune approximation dEuler de lequation

dierentielle stochastique bi-dimensionnelle suivante

dU

t

= B(U

t

)dt + (U

t

)dW

t

avec U

t

=

_

S

t

Y

t

_

, B(U

t

) =

_

rS

t

S

t

_

and (U

t

) =

_

(S

t

)

0

_

Schemas dordre superieur

Une mani`ere de construire des schemas plus precis est de remarquer que dans L

2

, la variable

aleatoire la plus proche de

_

1

T

_

T

0

S

s

ds K

_

+

, quand les (S

t

k

, k = 0, . . . , N) sont connus

est donnee par

E

__

1

T

_

T

0

S

u

du K

_

+

B

h

_

, (2.9)

o` u B

h

est la tribu engendree par les (S

t

k

, k = 0, . . . , N). Bien evidemment, il est impossible

de calculer exactement cette esperance conditionnelle (cela est plus dicile que de calculer

une formule explicite pour V ).

Mais comme la loi conditionnelle de W

u

par rapport ` a B

h

pour u [t

k

, t

k+1

] peut etre

formellement decrite, on peut calculer

_

E

_

1

T

_

T

0

S

u

du

B

h

_

K

_

+

=

_

1

T

_

T

0

E

_

S

u

B

h

_

du K

_

+

(2.10)

en tant que fonction de (W

t

k

, k = 0, . . . , N). Linegalite de Jensen prouve que (2.10) est plus

petit que (2.9), mais on va voir que (2.9) est dej` a une bonne approximation de Y

T

. Utilisant

la loi decrite par

L(W

u

[ W

t

k

= x, W

t

k+1

= y) = ^

_

t

k+1

u

h

x +

u t

k

h

y,

(t

k+1

u)(u t

k

)

h

_

, (2.11)

on obtient

E

_

1

T

_

T

0

S

u

du

B

h

_

=

1

T

N1

k=0

_

t

k+1

t

k

e

(r

2

2

)u

e

t

k+1

u

h

Wt

k

+

ut

k

h

Wt

k+1

+

2

2

(t

k+1

u)(ut

k

)

h

du

=

1

T

N1

k=0

_

t

k+1

t

k

e

ut

k

h

(Wt

k+1

Wt

k

)

2

2

(ut

k

)

2

h

+ru

e

Wt

k

2

2

t

k

du

Dans une methode de Monte Carlo, cette approximation est utilisee dans une double boucle

(en temps et en nombre de simulations). Il est necessaire de simplier cette formule, et, une

application de la formule de Taylor (avec h petit) conduit au schema dapproximation plus

simple suivant

Y

e,N

T

=

h

T

N1

k=0

S

t

k

_

1 +

rh

2

+

W

t

k+1

W

t

k

2

_

. (2.12)

2.3. M

ETHODES SP

ECIALES POUR LES OPTIONS EXOTIQUES 19

Remarque 2.6. Notons que ce schema est equivalent ` a la formule des trap`ezes. En eet

on montre que

E

_

Y

e,N

T

1

T

N1

k=0

h

S

t

k

+S

t

k+1

2

_

2

= O

_

1

N

3

_

.

Or, comme la vitesse de convergence de (2.12) est en 1/N.

Demonstration. Ce resultat peut etre obtenu en utilisant la formule de Taylor

1

T

N1

k=0

h

S

t

k

+S

t

k+1

2

=

1

T

N1

k=0

hS

t

k

2

(e

(Wt

k+1

Wt

k

)

2

2

h+rh

+ 1)

=

1

T

N1

k=0

hS

t

k

2

(2 +(W

t

k+1

W

t

k

) +rh +O(h(W

t

k+1

W

t

k

)))

ce qui est exactement le schema (2.12). Le terme dordre

2

h et la variation quadratique

(W

t

k+1

W

t

k

) sannule. Utilisant Cauchy-Schwarz on obtient le resultat voulu.

Le dernier schema est tr`es semblable. Comme le mouvement Brownien est un processus

gaussien,

_

T

0

W

u

du suit une loi normale sur R et peut etre facilement simule. Il est alors

naturel de chercher des schemas de discretisation de

_

T

0

S

s

ds faisant intervenir

_

T

0

W

s

ds. Par

exemple, on peut proceder de la mani`ere suivante :

Y

T

=

1

T

_

T

0

S

u

du

=

1

T

N1

k=0

S

t

k

_

t

k+1

t

k

e

(WuWt

k

)

2

2

(ut

k

)+r(ut

k

)

du.

En utilisant formellement la formule de Taylor, on obtient

Y

p,N

T

=

1

T

N1

k=0

S

t

k

_

h +

rh

2

2

+

_

t

k+1

t

k

(W

u

W

t

k

)du

_

. (2.13)

Remarque 2.7. En pratique pour simuler ce schema, on doit, ` a chaque etape simuler W

t

k+1

sachant W

t

k

et (

_

t

k+1

t

k

W

u

du [ W

t

k

, W

t

k+1

). Pour la seconde variable on utilise la loi (2.9) et

pour la premi`ere on remarque que (W

t

k+1

W

t

k

, k = 0, . . . , N 1) est une suite de variables

gaussiennes i.i.d.

Remarque 2.8. Ce schema est generalisable ` a une classe plus large de processus. Soit S

t

une diusion de derive b(S

t

), de derive (S

t

), et Y

t

=

_

S

t

dt. On peut utiliser un schema

classique pour approcher S

t

par S

N

t

et poser

Y

N

T

=

N1

k=0

S

n

t

k

_

h +

_

t

k+1

t

k

(S

N

s

S

N

t

k

)ds

_

.

20 CHAPITRE 2. SCH

EMAS DAPPROXIMATION DEDS

Mais si la diusion S

t

est directement simulable aux instants t

k

, il sut dutiliser

Y

N

T

=

N1

k=0

S

t

k

_

h +

_

t

k+1

t

k

(S

N

s

S

t

k

)ds

_

.

Toutefois, si lordre de convergence du schema utilise pour S nest pas meilleur que 1/N

3/2

,

cela na pas dinteret car lerreur globale sera limitee par celle du premier schema.

Convergence dans les espaces L

p

Dans tout ce qui suit on va se ramener ` a S

0

= 1. Si S

0

= s nest pas une variable aleatoire,

il sut de considerer S

t

/s (on note que si s = 0 le probl`eme pose est trivial).

Soit un schema dapproximation de Y

t

. Si on sinteresse ` a des schemas B

h

mesurables alors

on sait que lesperance conditionnelle va etre optimale dans L

2

. Le but est de comparer les

dierents schemas. On commence par rappeler deux resultats importants.

Proposition 2.5. Pour une diusion de type Black et Scholes

E[S

t

S

s

[

2q

C

q

[t s[

q

.

Cette proposition est valable pour toute diusion avec des coecients lipschitziens (cf. [52]).

Le resultat suivant est aussi tr`es utile (voir [23] chapitre 3 pour une preuve) :

Lemme 2.6. Soit Z

t

= Z

0

+

_

t

0

A

s

dW

s

+

_

t

0

B

s

ds o` u B

s

est un vecteur dans R

n

, A

s

une

matrice de R

nd

, et W

t

un mouvement Brownien ddimensionnel. (Z

t

est un processus dIt o

donc A et B sont adaptes,

_

[A

s

[ds < + and E

_

B

2

s

ds < +).

Alors, Z

t

satisfait

E[Z

t

[

p

E[Z

0

[

p

+C

_

t

0

E([Z

s

[

p

+[A

s

[

p

+[B

s

[

p

)ds

On peut maintenant obtenir des resultats precis de convergence pour nos trois schemas

Proposition 2.7. Avec les notations ci-dessus, il existe trois fonctions strictement crois-

santes K

1

(T), K

2

(T), K

3

(T) telles que,

_

E

_

sup

t[0,T]

[Y

r,N

t

Y

t

[

2q

__ 1

2q

K

1

(T)

N

, (2.14)

_

E

_

sup

t[0,T]

[Y

e,N

t

Y

t

[

2q

__ 1

2q

K

2

(T)

N

, (2.15)

_

E

_

sup

t[0,T]

[Y

p,N

t

Y

t

[

2q

__ 1

2q

K

3

(T)

N

3/2

. (2.16)

2.3. M

ETHODES SP

ECIALES POUR LES OPTIONS EXOTIQUES 21

Fig. 2.1 Limites de la methode nave dapproximation

2.3.2 Options sur maximum

Introduction

On consid`ere dans cette partie des payo du type

f(X

T

, M

T

),

o` u (X

t

, t 0) est solution de lEDS en dimension 1,

dX

t

= b(X

t

)dt +(X

t

)dW

t

,

et M

T

= max

sT

X

s

.

Approche nave La methode devaluation la plus simple est de calculer le maximum sur

la trajectoire. On va approcher M

T

par

M

T

= max

0kn

X

n

kh

,

Notons que sous certaines conditions de regularite on montre que (voir [54]) lerreur secrit

comme

E(f(X

T

, M

T

)) E

_

f(

X

n

T

,

M

n

T

)

_

=

C

n

(1 +(n)),

o` u lim

n+

(n) = 0. Ce resultat est surprenant. En eet, si f ne depend pas de M

T

, on a

vu que lordre de convergence etait en h. La gure 2.3.2 montre quen fait le maximum peut

ne pas se situer en un instant de discretisation et etre meme tr`es dierent. Cependant on

peut tr`es facilement ameliorer ce resultat (voir [30, 31, 32], [1, 3, 2]).

Utilisation des ponts browniens

Lidee de base est que lon peut simuler, apr`es discretisation, la loi du maximum du processus

(

X

n

t

, 0 t T) o` u

X

n

t

=

X

n

kh

+b(

X

n

kh

)(t kh) +(

X

n

kh

)(W

t

W

kh

).

conditionnellement `a (

X

n

kh

, 0 k N). Pour cela, nous avons besoin de quelques notions sur

les ponts Browniens :

Proposition 2.8. Soit (W

t

)

t0

un mouvement Brownien. Le processus (Z

t

)

0t<T

deni par

Z

t

= W

t

t

T

W

T

est un processus gaussien independant de W

T

. De plus,

E[Z

t

] = 0 t [0, T]

E[Z

t

Z

s

] = s t

st

T

(s, t) [0, T]

2

22 CHAPITRE 2. SCH

EMAS DAPPROXIMATION DEDS

Enn, le mouvement Brownien conditionne par W

T

= y a meme loi que

Z

y

t

= W

t

t

T

(W

T

y).

Demonstration. Pour tous 0 t

1

< . . . < t

k

< T, le vecteur aleatoire (Z

t

1

, . . . , Z

t

k

, W

T

) est

gaussien centre en tant quimage dun vecteur gaussien centre par une application lineaire.

En particulier, (Z

t

)

t[0,T]

est un processus gaussien centre.

De plus,

Cov(Z

t

i

, W

T

) = E[W

t

i

W

T

]

t

i

T

E

_

W

2

T

= 0.

do` u lindependance de (Z

t

1

, . . . , Z

t

k

) et W

T

puis celle de Z

t

, t [0, T] et W

T

par un argument

de classe monotone.

On a dej` a vu que Z est centre et pour s t

E[Z

s

Z

t

] = E[W

s

W

t

]

t

T

E[W

s

W

T

]

s

T

E[W

t

W

T

] +

st

T

2

E

_

W

2

T

= s

st

T

.

Do` u en symetrisant

E[Z

s

Z

t

] = s t

st

T

.

Pour la derni`ere armation, nous renvoyons ` a [52] p.39.

Appliquons maintenant ce resultat au schema dEuler :

Proposition 2.9. On suppose que ne sannule pas pour tout x R. Alors conditionnelle-

ment ` a (

X

n

t

k

= x

k

,

X

n

t

k+1

= x

k+1

), le processus (

X

n

)

t[t

k

,t

k+1

]

a la loi de (x

k

+ (x

k

)Z

tt

k

)

o` u Z est le pont Brownien

Z

tt

k

= W

tt

k

t t

k

t

k+1

t

k

_

W

t

k+1

t

k

x

k+1

x

k

(x

k

)

_

.

Cest un processus gaussien desperance x

k

t

k+1

t

t

k+1

t

k

+x

k+1

tt

k

t

k+1

t

k

et de variance

(t t

k

)(t

k+1

t)

t

k+1

t

k

(x

k

)

2

.

Demonstration. Immediat dapr`es la proposition precedente.

Finalement il est necessaire davoir des renseignements sur la fonction de repartition du

maximum dun pont Brownien :

Proposition 2.10. Soit Z

t

= W

t

t

T

(W

T

y), le pont Brownien valant y quand t = T.

Alors, pour tout a > y,

P

_

max

t[0,h]

Z

t

a

_

= 1 e

2

h

a(ay)

.

2.3. M

ETHODES SP

ECIALES POUR LES OPTIONS EXOTIQUES 23

Demonstration. Dapr`es la proposition 2.8, Z

t

a meme loi que W

t

[ W

h

= y. Soit

a

:= inft

0 : W

t

= a , le temps datteinte de a par W. On a alors,

P

_

max

t[0,h]

W

t

a , W

h

y

_

= P(

a

h , W

h

y) = P(

a

h , W

h

W

a

y a) .

Comme

a

est T

W

a

mesurable et que W

h

W

a

est independant de T

W

a

par la propriete de

Markov forte du mouvement Brownien, on obtient

P

_

max

t[0,h]

W

t

a , W

h

b

_

= P(

a

h , W

h

W

a

a y)

= P(

a

h , W

h

2a y)

car W

h

W

a

et W

a

W

h

ont la meme loi (propriete de symetrie). Comme 2a y a, on

a donc

P

_

max

t[0,h]

W

t

a , W

h

b

_

= P(W

h

2a y) .

Finalement, comme

P

_

max

t[0,h]

W

t

a [ W

h

= y

_

= 1

y

P

_

max

t[0,h]

W

t

a , W

h

y

_

y

P(W

h

y)

,

un calcul direct donne le resultat.

En couplant les propositions 2.10 et 2.9, on saper coit que la loi du maximum du schema

dEuler entre t

k

et t

k+1

a pour fonction de repartition :

P

_

max

t

k

tt

k+1

X

n

t

a [

X

n

t

k

= x

k

,

X

n

t

k+1

= x

k+1

_

= 1 e

2

h

(ax

k

)(ax

k+1

)

2

(x

k

)

:= F

h

(a, x

k

, x

k+1

).

Son inverse etant

F

1

h

(U, x

k

, x

t

k+1

) =

1

2

_

x

k

+x

k+1

+

_

(x

k+1

x

k

)

2

2

2

(x

k

)hln(U)

_

(2.17)

On peut simuler la loi de m

k

= max

t

k

tt

k+1

X

n

t

par F

1

h

(U

k

, x

k

, x

t

k+1

) o` u les U

k

sont des

variables independantes de loi uniforme sur [0, 1] . On denit une approximation de M

T

en

utilisant

M

T

= sup

1kN

m

k

.

Ce schema est facile `a implementer :

24 CHAPITRE 2. SCH

EMAS DAPPROXIMATION DEDS

For i=1 to n

S(k+1) = S(k) * exp((r-sigma^2/2) h + sigma*sqrt(h)*gauss(k)

G en` ere U

Calcul de mk par (2.17)

end

On peut par ailleurs montrer (voir [32]) que sous certaines conditions de regularite, il est

dordre 1/n. On peut generaliser ce procede quand d > 1 en prenant le maximum sur chaque

composante de X.

2.3.3 Options barri`eres

Dans cette partie, X designera la solution de lequation dierentielle stochastique multi-

dimensionnelle :

dX

t

= b(X

t

)dt +(X

t

)dW

t

, X

0

= x R

d

.

On sinteresse `a levaluation desperance de la forme :

E[g(X

T

)1

>T

] o` u , := inft [0, T] : X

t

/ D, (2.18)

o` u D est un borelien de R

d

. represente le temps de sortie de cet ensemble, avec pour

convention inf = +.

Ces options sont en dimension 1 des cas particuliers des options sur maximum.

Approche nave

On commence par lapproche la plus simple qui consiste ` a approcher (2.18) par son equivalent

discret

E

_

1

n

>T

g(

X

n

T

)

o` u

n

:= inft

i

, i 0, . . . , n :

X

n

t

i

/ D (2.19)

est lequivalent discret de . Cette quantite est facilement simulable et on a le resultat de

convergence suivant demontre dans [32].

Theor`eme 2.11. Si D est borne de fronti`ere D de classe

1

C

3

, b et C

3

avec a strictement

uniformement elliptique

2

sur D, alors, pour toute fonction mesurable g bornee qui sannule

sur un voisinage de D, on a

E

_

1

n

>T

g(

X

n

T

)

E[1

>T

g(X

T

)] = O

_

1

n

_

.

1

i.e. pour tout y D, il existe un voisinage V (y) de y et un dieomorphisme de V (y) B R

d

tels

que

(i) (V (y) D) R

d

+

:=

_

x R

d

: x

1

0

_

(ii) (V (y) D) R

d

+

(iii) C

3

(V (y)) et

1

C

3

(B).

2

i.e. tel que x D |(x)

(x)| > .

2.3. M

ETHODES SP

ECIALES POUR LES OPTIONS EXOTIQUES 25

Il sagit dun resultat assez negatif dans la mesure o` u lon perd la vitesse de convergence

faible obtenue pour les options vanilla.

Approche par les ponts de diusion

Dans cette partie, nous presentons une autre approche qui permet dameliorer la vitesse de

convergence faible du Theor`eme 2.11. Cest lequivalent pour les options barri`eres de ce que

lon a vu au chapitre precedant pour les lookback. Cette fois-ci on approche (2.18) par

E

_

1

n

>T

g(

X

n

T

)

o` u

n

:= inft [0, T] :

X

n

t

/ D (2.20)

cest-` a-dire que lon ecrit le probl`eme sur le schema dEuler continu. On a alors le resultat de

convergence suivant demontre dans [33].

Theor`eme 2.12. Si D est un demi-espace, b et C

5

avec strictement uniformement

elliptique sur D, alors, pour toute fonction mesurable g bornee qui sannule sur un voisinage

de D, on a

E

_

1

n

>T

g(

X

n

T

)

E[1

>T

g(X

T

)] =

C

1

n

+o

_

1

n

_

.

On retrouve ainsi une vitesse de convergence faible en 1/n.

Sur les ponts de diusions An dimplementer cette approximation, on aura besoin

du resultat suivant sur la loi du schema dEuler continu conditionne. Cette proposition est

lanalogue de 2.9 en dimension d > 1.

Lemme 2.13. On suppose que (x) = ((x)

(x))

1/2

est inversible pour tout x R

d

. Alors,

conditionnellement ` a (

X

n

t

i

= x

i

,

X

n

t

i+1

= x

i+1

), le processus (

X

n

t

)

t

i

tt

i+1

a la loi de

_

x

i

+(x

i

)

W

tt

i

_

t

i

tt

i+1

conditionnellement ` a

W

t

i+1

t

i

= (x

i

)

1

(x

i+1

x

i

)

o` u

W est un mouvement brownien. Cest un processus gaussien desperance x

i

t

i+1

t

t

i+1

t

i

+

x

i+1

tt

i

t

i+1

t

i

et de matrice de variance-convariance

(st

i

)(t

i+1

t)

t

i+1

t

i

(x

i

)

2

pour tout t

i

s t

t

i+1

.

Elements de preuve. Conditionellement ` a

X

n

t

i

= x

i

, (

X

n

t

)

t

i

tt

i+1

est un processus de

diusion homog`ene qui admet pour densite de transition

p

h

(x, z) =

exp

_

1

2h

(z x b(x

i

)h)

(

2

(x

i

)) (z x b(x

i

)h)

_

_

(2h)

d

det[

2

(x

i

)]

.

Pour t

i

s t t

i+1

P

_

X

n

s

dx,

X

n

t

dy,

X

n

t

i+1

dx

i+1

[

X

n

t

i

= x

i

_

dxdydx

i+1

= p

st

i

(x

i

, x)p

ts

(x, y)p

t

i+1

t

(y, x

i+1

)

P

_

X

n

s

dx,

X

n

t

i+1

dx

i+1

[

X

n

t

i

= x

i

_

= p

st

i

(x

i

, x)p

t

i+1

s

(x, x

i+1

)dxdx

i+1

.

26 CHAPITRE 2. SCH

EMAS DAPPROXIMATION DEDS

En divisant le premier terme par le second, on obtient :

P

_

X

n

t

dy [

X

n

s

= x,

X

n

t

i

= x

i

,

X

n

t

i+1

= x

i+1

_

=

p

ts

(x, y)p

t

i+1

t

(y, x

i+1

)

p

t

i+1

s

(x, x

i+1

)

dy .

Ceci montre que

p

t

i+1

,x

i+1

t

i

,x

i

(s, x, t, y) :=

p

ts

(x, y)p

t

i+1

t

(y, x

i+1

)

p

t

i+1

s

(x, x

i+1

)

est la densite de transition du processus (

X

n

t

)

t

i

tt

i+1

conditionnellement ` a (

X

n

t

i

= x

i

,

X

n

t

i+1

=

x

i+1

). Le reste en decoule par des calculs directs.

Remarque 2.9. En utilisant la propriete de Markov de

X

n

, on verie facilement que les

processus (

X

n

t

)

t

i

tt

i+1

pour i allant de 0 ` a n 1 sont independants conditionnellement ` a

X

n

t

0

, . . . ,

X

n

tn

.

Implementation On peut maintenant decrire la methode. On commence par simuler le

schema dEuler (

X

n

t

i

)

n

i=1

et on ecrit

E

_

1

n

>T

g(

X

n

T

)

= E

_

E

_

1

n

>T

[ (

X

n

t

i

)

n

i=1

g(

X

n

T

)

ce qui signie quil faut calculer E1

n

>T

[ (

X

n

t

i

)

n

i=1

, une fois la trajectoire discr`ete (

X

n

t

i

)

n

i=1

simulee.

Evidemment si un des

X

n

t

i

nest pas dans D, il ny a rien ` a faire et le payo de

loption donne 0. On ne calcule donc cette probabilite que si les

X

n

t

i

simules sont tous dans

D.

Pour cela, on va utiliser les resultats de la section precedente. Tout dabord, la Remarque 2.9

implique que

E

_

1

n

>T

[ (

X

n

t

i

)

n

i=1

=

n1

i=0

P

_

t [t

i

, t

i+1

],

X

n

t

D [

X

n

t

i

,

X

n

t

i+1

_

.

Nous allons maintenant montrer que, dans le cas o` u D est un demi-espace, le calcul est

explicite. On ecrit D sous la forme

D = y R

d

:

(y ) > 0 (2.21)

i.e.

D est lhyperplan passant par R

d

orthogonal ` a R

d

.

Exemple 2.1. Pour une barri`ere haute U en dimension 1, on a D = (, U), ce qui donne

= U et = 1.

On xe i 0, . . . , n 1. Dapr`es la proposition 2.10, on a

P

_

t [t

i

, t

i+1

],

X

n

t

/ D [

X

n

t

i

= x

i

,

X

n

t

i+1

= x

i+1

_

= P

_

t [t

i

, t

i+1

],

(x

i

)

W

tt

i

( x

i

) [

W

t

i+1

t

i

= (x

i

)

1

(x

i+1

x

i

)

_

.

2.3. M

ETHODES SP

ECIALES POUR LES OPTIONS EXOTIQUES 27

On choisit maintenant une matrice P orthogonale

3

telle que P

1

=

1

(x

i

)

(x

i

). Le pro-

cessus

W

t

i

= (P

W

tt

i

)

t[t

i

,t

i+1

]

a la meme loi que

W. Par ailleurs

(x

i

)

W

tt

i

=

(x

i

)P

W

tt

i

= |(x

i

)|

W

1

tt

i

car le vecteur ligne

(x

i

)P

a seulement sa premi`ere composante non nulle, egale ` a |(x

i

)|.

En re-injectant ce resultat dans les egalites precedentes, on obtient

P

_

t [t

i

, t

i+1

],

X

n

t

/ D [

X

n

t

i

= x

i

,

X

n

t

i+1

= x

i+1

_

= P

_

t [t

i

, t

i+1

],

W

1

tt

i

( x

i

)

|(x

i

)|

[

W

1

t

i+1

t

i

=

(x

i+1

x

i

)

|(x

i

)|

_

= P

_

min

t[t

i

,t

i+1

]

W

1

tt

i

( x

i

)

|(x

i

)|

[

W

1

t

i+1

t

i

=

(x

i+1

x

i

)

|(x

i

)|

_

.

Cette probabilite se calcule facilement en utilisant le principe de reexion du Brownien (voir

proposition 2.10)

P

_

min

t[t

i

,t

i+1

]

W

1

tt

i

a [

W

1

t

i+1

t

i

= b

_

= e

2

n

T

a(ab)

a 0 et b a (2.22)

que lon applique `a b =

(x

i+1

x

i

)

(x

i

)

et a =

(x

i

)

(x

i

)

. Puisque lon ne fait ce calcul que si x

i

D, on verie bien que a 0 et b a. Finalement, on a montre que

Proposition 2.14. Si (x)

2

est inversible pour tout x R

d

et si D est donne par (2.21),

alors pour tout x

i

, x

i+1

D, on a

P

_

t [t

i

, t

i+1

],

X

n

t

D [

X

n

t

i

= x

i

,

X

n

t

i+1

= x

i+1

_

= 1 exp

_

2

n

T

(

( x

i

))

( x

i+1

))

|(x

i

)|

2

_

. (2.23)

Lorsque D nest pas un demi-espace, on na en general plus de forme explicite pour (2.23).

On peut toutefois essayer dapprocher D par son hyperplan tangent en

D

(x

i

), le projete

de x

i

sur la fronti`ere de D. Si D est de classe C

5

, on retrouve la vitesse en 1/n du Theor`eme

2.12, voir [33].

Exemple 2.2. On evalue un call up-and-out

E

_

1

max

t[0,T]

Xt<U

[X

T

K]

+

_

dans le mod`ele de Black-Scholes de param`etres r = 0, = 0.15, T = 1, X

0

= 100, K =

90, U = 130. Le tableau ci-dessous donne les intervalles de conance simules pour les deux

methodes (nave et par pont), le prix reel etant denviron 9.21. On eectue ` a chaque fois

30.000 simulations.

Nombre de pas de temps Methode Nave Methode par pont

10 [9.84 , 9.97] [9.18 , 9.31]

50 [9.46 , 9.60] [9.14 , 9.27]

100 [9.40 , 9.54] [9.16 , 9.30]

3

i.e. PP

= P

P = I

d

.

28 CHAPITRE 2. SCH

EMAS DAPPROXIMATION DEDS

La sur-estimation de la methode nave est agrante : il est absolument necessaire dutiliser

la methode tenant compte de la probabilite de sortie de D entre deux dates de discretisation.

Chapitre 3

Reduction de variance

Nous avons vu que lerreur due ` a une methode de Monte Carlo pour le calcul de E[f(S

T

)]

est liee soit `a la discretisation du processus S

T

soit ` a lapproximation de lesperance par une

moyenne trajectorielle. Nous avons egalement observe que dans certains cas de payo, il etait

possible de reduire considerablement lerreur de discretisation. Dans ce chapitre nous allons

nous interesser au deuxi`eme type derreur.

3.1 Fonctions dimportance

3.1.1 Un exemple en nance

Supposons que le processus S obeit ` a lequation de Black et Scholes ` a 1 dimension

dS

t

= rS

t

dt +S

t

dW

t

, (3.1)

lon et que lon veuille calculer un call :

E[(S

T

)] =

_

S

0

e

W

T

+(r

2

/2)T

K

_

+

,

avec S

0

K (call tr`es en dehors de la monnaie).

Si on eectue une methode de Monte Carlo classique, sur toutes les trajectoires simulees, tr`es

peu seront au dessus de K et donc tr`es peu compteront (car P

_

S

0

e

TG+(r

2

/2)T

> K

_

est tr`es faible). Dans ce cas on simule :

E[f(G)] f(x) =

_

S

0

e

Tx+(r

2

/2)T

K

_

+

.

Au lieu de simuler G, nous allons simuler H = G + m o` u m est reel que lon choisira

ulterieurement. La loi de H a pour densite

h(x) =

e

1

2

(xm)

2

2

.

On a

E[f(G)] = E

_

f(H)

h(G)

h(H)

_

= E

_

f(H)e

mH+

m

2

2

_

.

29

30 CHAPITRE 3. R

EDUCTION DE VARIANCE

Pour choisir un m approprie f doit etre donne. Dans le cas du call tr`es en dehors de la

monnaie, on va sarranger pour que P[S

0

e

TH+(r

2

/2)T

> K] ne soit plus negligeable. Par

exemple, on peut choisir (ce nest pas optimal) m tel que S

0

e

m

T+(r

2

/2)T

= K et donc

P[S

0

e

TH+(r

2

/2)T

> K] =

1

2

.

Application : on donne r = 0, = 0.2, T = 1, K = 100, S

0

= 70. Le vrai prix est de .248.

Methode Nombre de trajectoires Valeur Intervalle de conance

Classique 1000 0.29 [..021 , .57]

Classique 10000 0.288 [.18 , .39]

Classique 100000 0.255 [.23 , .28]

Importance 1000 0.246 [.24 , .25]

Importance 10000 0.239 [.238 , .241]

Importance 100000 0.247 [.247 , .248]

On voit bien quun Monte Carlo classique a une variance trop grande.

3.1.2 Generalites

La methode de fonction dimportance consiste ` a changer la loi de simulation dans le but de

reduire la variance.

Supposons que lon veuille calculer

E(g(X)),

Xest une variable aleatoire de densite f(x) on R, alors

E(g(X)) =

_

R

g(x)f(x)dx.

Soit

fune autre densite telle que

f(x) > 0 et

_

R

f(x)dx = 1. Alors on peut ecrire E(g(X))

comme

E(g(X)) =

_

R

g(x)f(x)

f(x)

f(x)dx = E

_

g(Y )f(Y )

f(Y )

_

,

si Y a pour densite

f(x) sous P. Nous avons obtenu une autre methode pour simuler E(g(X))

en utilisant n trajectoires selon la loi de Y , (Y

1

, . . . , Y

n

)

1

n

_

g(Y

1

)f(Y

1

)

f(Y

1

)

+ +

g(Y

n

)f(Y

n

)

f(Y

n

)

_

.

On pose Z = g(Y )f(Y )/

f(Y ), lalgorithme sera alors plus ecace si Var(Z) < Var (g(X)).